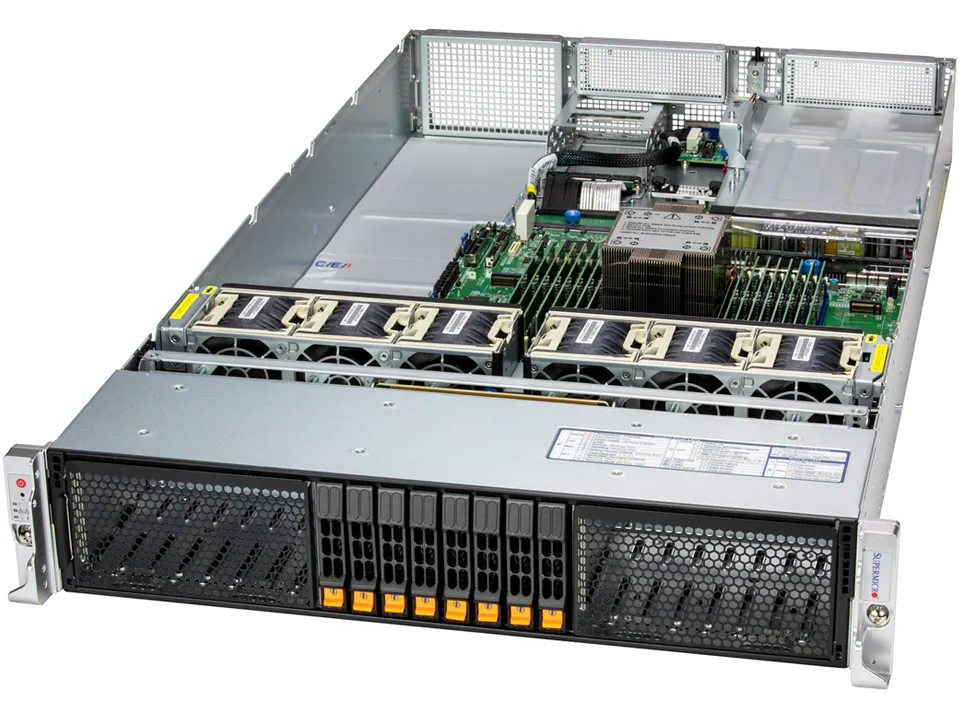

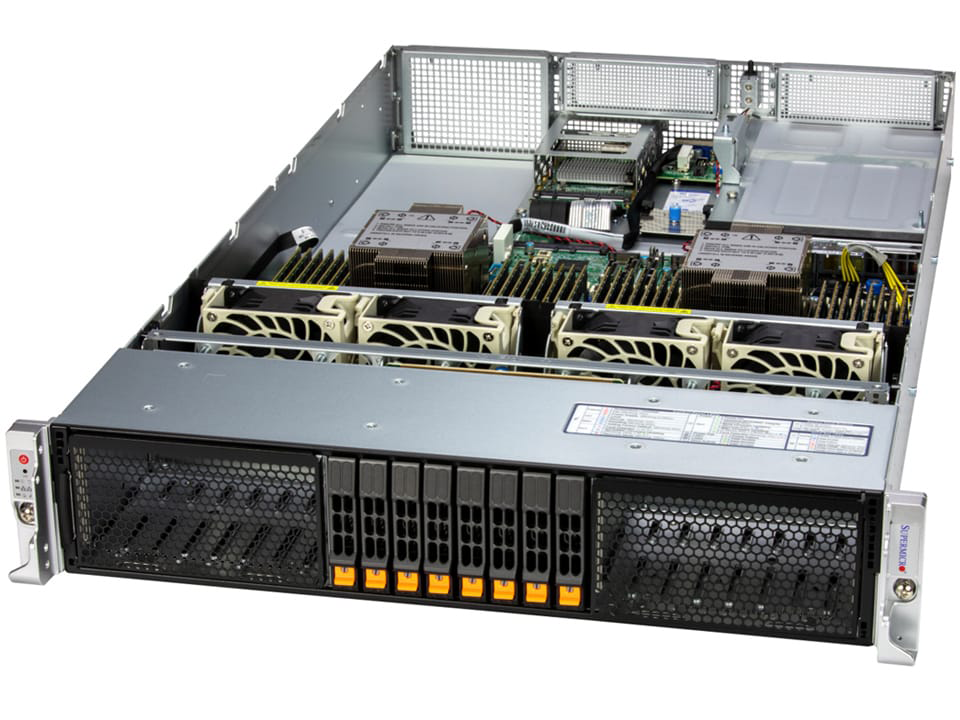

NVIDIA データセンターGPU搭載製品

サーバー向けデータ センター GPU

NVIDIA データセンターGPUは、HPC分野における複雑で膨大な計算を高速で行うワークロードに対応します。

GPU単体で高い計算能力を持ち、使用用途に応じた製品が選択可能な他、複数枚構成やGPUの組換えでスケールアウトやスケールアップを実現。

今やGPGPU分野においてスタンダードとなった開発環境であるCUDAをベースに幅広いアプリケーションやAI処理を可能にし、最高のパフォーマンスとユーザー密度をもたらします。