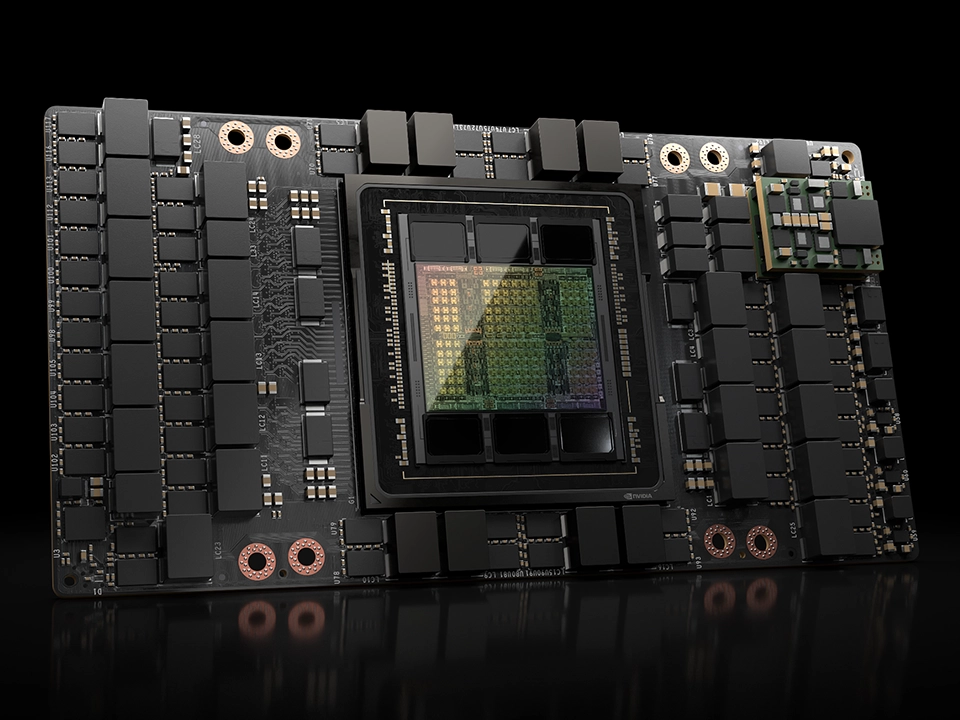

NVIDIA H200 TensorコアGPUは、市場を一変させるパフォーマンスとメモリ機能で生成AIとHPCワークロードを強化します。HBM3eを搭載した初のGPUであるH200の大容量かつ高速のメモリは、HPCワークロードのための科学コンピューティングを推進しながら、生成AIと大規模言語モデル(LLM)の高速化を促進します。

|

|

|---|---|

| FP64(TFLOPS) | 34 |

| FP64 Tensor コア(TFLOPS) | 67 |

| FP32(TFLOPS) | 67 |

| TF32 Tensor コア(TFLOPS) | 989 |

| BFLOAT16 Tensorコア(TFLOPS) | 1,979 |

| FP16 Tensorコア(TFLOPS) | 1,979 |

| FP8 Tensorコア(TFLOPS) | 3,958 |

| INT8 Tensorコア(TOPS) | 3,958 |

| GPUメモリ | 141GB |

| GPUメモリー帯域幅 | 4.8TB/s |

| デコーダー | 7 NVDEC 7 JPEG |

| コンフィデンシャル コンピューティング | サポート対象 |

| 最大熱設計電力(TDP) | 最大700W(構成可能) |

| マルチインスタンスGPU | 各18GBで最大7個のMIG |

| フォームファクター | SXM |

| 相互接続 | NVLink : 900 GB/s PCIe Gen5 : 128 GB/s |

| NVIDIA AI Enterprise | アドオン |

| 排熱機構 | パッシブ(冷却ファンなし) |

生成AIとHPCのためのGPU

NVIDIA H200 TensorコアGPUは、市場を一変させるパフォーマンスとメモリ機能で生成AIとHPCワークロードを強化します。HBM3eを搭載した初のGPUであるH200の大容量かつ高速のメモリは、HPCワークロードのための科学コンピューティングを推進しながら、生成AIと大規模言語モデル(LLM)の高速化を促進します。

NVIDIA H200のイノベーション

大容量で高速なメモリによる高いパフォーマンス

NVIDIA HopperアーキテクチャをベースとするNVIDIA H200は、4.8TB/sで141GBのHBM3eメモリを提供する初のGPUです。これは、NVIDIA H100 TensorコアGPUの約2倍の容量で、メモリ帯域幅は1.4倍です。H200の大容量かつ高速なメモリは、生成AIとLLMを加速し、エネルギー効率を向上させ、総所有コストを低減し、HPCワークロードのための科学コンピューティングを前進させます。

高性能なLLM推論でインサイトを引き出す

進化し続けるAIの世界では、企業はさまざまな推論のニーズに対応するためにLLMを利用しています。AI推論アクセラレータは、大規模なユーザーベース向けにデプロイする場合、最小のTCOで最高のスループットを実現する必要があります。

H200は、Llama2のようなLLMを扱う場合、H100 GPUと比較して推論速度を最大2倍向上します。

ハイパフォーマンスコンピューティングをスーパーチャージ

メモリ帯域幅は、より高速なデータ転送を実現することで、ボトルネックとなる複雑な処理を削減するため、ハイパフォーマンスコンピューティングアプリケーションにとって極めて重要です。シミュレーション、科学研究、人工知能のようなメモリを大量に使用するHPCアプリケーションでは、 H200の高いメモリ帯域幅が、データへのアクセスと操作を効率化し、CPUと比較して110倍の早さで結果を得ることができます。

エネルギーとTCOの削減

H200の導入により、エネルギー効率とTCOが新たなレベルに到達します。この最先端のテクノロジーは、すべてH100 TensorコアGPUと同じ電力プロファイル内で、かつてないパフォーマンスを提供します。AIファクトリーとスーパーコンピューティングシステムは、高速なだけでなく、環境にも優しく、AIと科学のコミュニティを推進する経済的優位性を提供します。