画像は実際の製品と異なる場合があります。

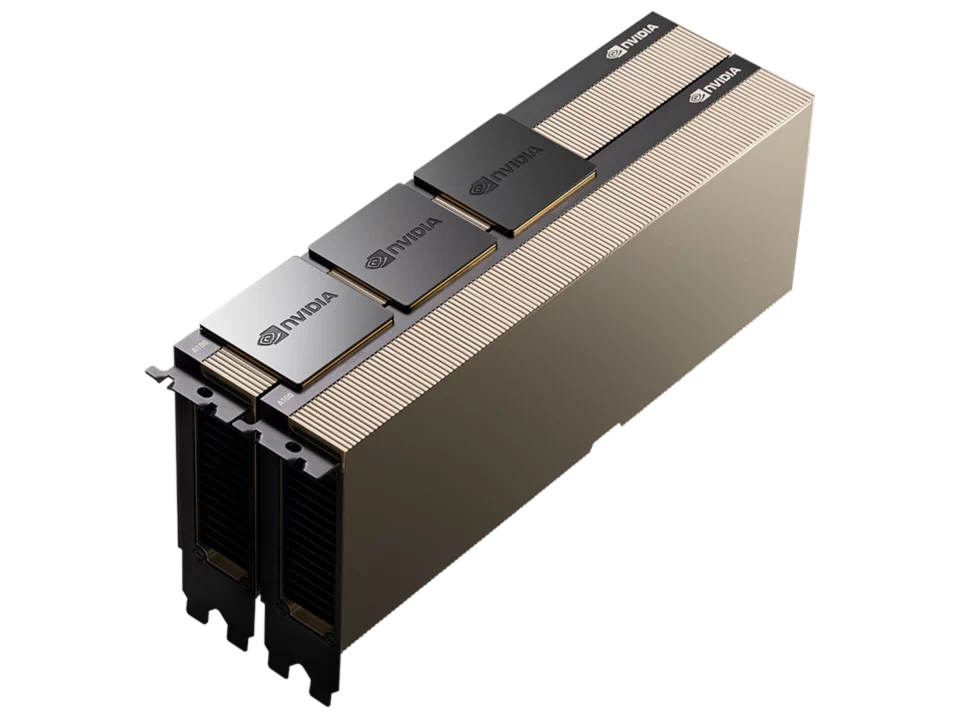

NVIDIA データセンターGPU 最大2基搭載

VCXS-W4USS06H1301-G

主な仕様

- 第5世代 インテル® Xeon® スケーラブル・プロセッサー 1基(Emerald Rapids / LGA4677 )

- DDR5-5600 メモリ 8スロット

- 2スロット PCIe GPU 最大2基 搭載可能

- 3.5 インチ ホットスワップ 6ベイ

- 2.5 インチ ホットスワップ 2ベイ

- 2.5 インチ NVMe 最大2台 搭載可能

- M.2 SSD 最大1枚 搭載可能

- 10 ギガビット イーサネット 2ポート

- タワー・ラックマウント両対応ケース

- シングル電源

スタンダード見積り

スペックと価格のバランスが

良い構成をご用意!

- とりあえず価格を知りたい

- 仕様が決まっていない

- 構成をおまかせしたい

- CPU

- インテル Xeon Silver 4516Y+ x 1

- メモリ

- 32GB x 8 DDR5-5600 ECC RDIMM

- M.2

- 1TB

- SSD

- 無し

- HDD

- 10TB

- 画面出力

- NVIDIA RTX A400 4GB GDDR6

- GPU

- NVIDIA RTX 6000 Ada 48GB GDDR6

- 電源

- 100V 1200W / 200V 1500W シングル電源

- OS

- Ubuntu Desktop LTS

カスタマイズ見積り

パーツ単位で自由な

カスタマイズが可能!

- ご希望の仕様がある

- パーツ毎に自分で選びたい

- こだわりの一台が欲しい

- CPU

- インテル Xeon スケーラブル・プロセッサー x 1

- メモリ

- DDR5-5600 ECC RDIMM x 8

- M.2

- 最大 8TB

- SSD

- 最大 7.68TB

- HDD

- 最大 24TB

- 画面出力

- NVIDIA RTX A400 4GB GDDR6 他

- GPU

- 2スロットGPU 最大 x 2

- 電源

- 100V 1200W / 200V 1500W シングル電源

- OS

- Linuxディストリビューション 他

製品特長

専用タワーケースにIntel® Xeon スケーラブル・プロセッサーを1基、NVIDIA GPUを最大2基搭載するハイパフォーマンスGPGPUモデルです。

本製品は高性能GPUを高密度に搭載することで高いエネルギー効率を発揮し、優れた費用対効果でコスト削減を実現します。

また、オプションパーツを使用することで4Uラックマウントとして運用できます。

第5世代 インテル® Xeon® スケーラブル・プロセッサー 搭載

NVIDIA データセンターGPU H200 NVL 搭載可能

NVIDIA RTX™ PRO Blackwell 搭載可能

製品仕様

| CPU | 第5世代 インテル Xeon スケーラブル・プロセッサー x 1 |

|---|---|

| チップセット | インテル C741 チップセット |

| メモリ | DDR5-5600MHz ECC RDIMM / 3DS RDIMM x 8 |

| ドライブベイ | 2.5インチ ホットスワップ ( SATA / NVMe 対応 ) x 2

3.5インチ ホットスワップ ( SATA / SAS 対応 ) x 6 |

| M.2スロット | インターフェイス : PCI-Express 3.0 ( NVMe 対応 ) フォームファクタ : 2280 x 1 |

| オプティカルドライブ | USB接続 外付けDVDマルチドライブ オプション |

| グラフィックス | オンボード |

| GPU | 2スロット GPU 最大 x 2 |

| ネットワークI/F | 10ギガビット イーサネット ( RJ45 ) x 2 + 1ギガビット イーサネット ( RJ45 ) x 1

or 1ギガビット イーサネット ( RJ45 ) x 1 |

| 管理I/F | BMC / IPMI 2.0 |

| I/Oポート 前面 | USB3.2 Gen1 x 2 |

| I/Oポート 背面 | シリアルポート x 1

VGA x 1 USB3.2 Gen1 x 2 USB2.0 x 2 IPMI用 MLAN ( RJ45 ) x 1 |

| 拡張スロット | PCI Express 5.0 x16 ( FHFL ) x 4

PCI Express 5.0 x8 ( FHFL ) x 1 |

| ケース | 専用タワーケース : W 176mm x H 438mm x D 650mm 4Uラックマウント時 : W 438mm x H 176mm x D 650mm オプション |

| 電源 | 100V 1200W / 200V 1500W シングル電源 |

| OS |

|

| 保守 | 1年間全国出張オンサイトサービス 3年間全国出張オンサイト オプション |

| 動作推奨環境 | 温度 : 10 ℃ ~ 35 ℃ 湿度 : 20 % ~ 80 % (結露なきこと) |

カタログ

弊社ウェブサイト(本サイト)に表示・記載されている会社名、製品名およびロゴ等は、各社の登録商標または商標です。