- NVIDIA データセンターGPU 搭載製品

- VCXS-2UDR08L1402-G

- NVIDIA RTX 搭載製品

- VCXS-2UDR08L1402-G

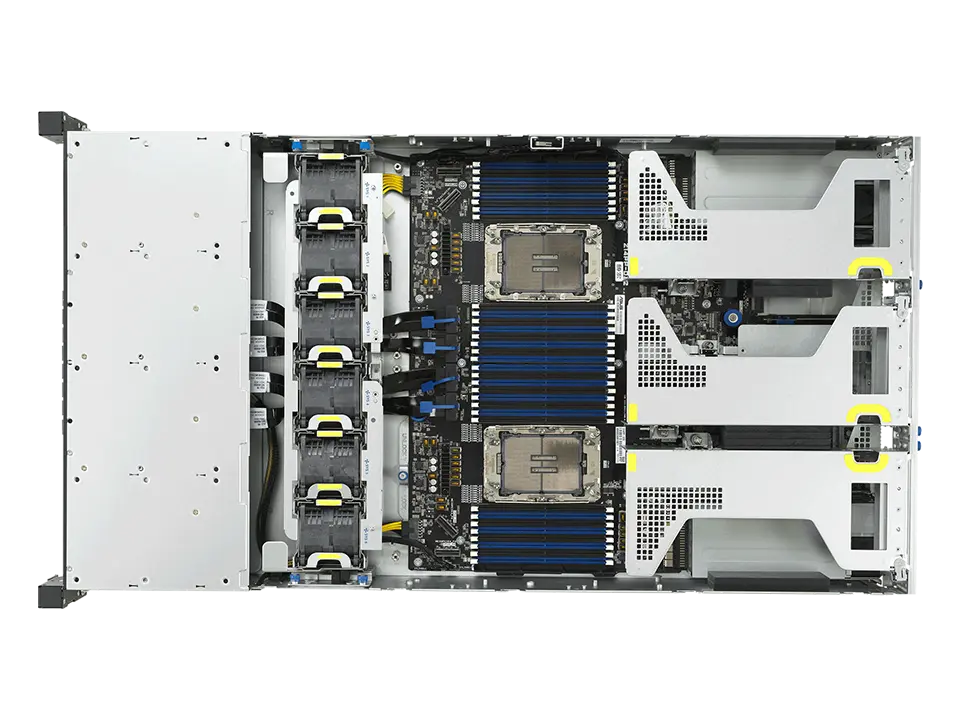

画像は実際の製品と異なる場合があります。

インテル® Xeon® 6 6700P/6500P/6700E プロセッサー搭載

VCXS-2UDR08L1402-G

2 基

32 枚

3 基

8 ベイ

2 枚

2U

冗長電源

10GbE

主な仕様

- インテル® Xeon® 6 6700P/6500P/6700E プロセッサー 2基

(Granite Rapids,Sierra Forest / LGA4710 ) - DDR5-6400 メモリ対応

- 2 スロット GPU 最大3基 搭載可能

- PCI-Express 5.0 x16 5スロット

- 2.5 インチ ホットスワップ 8ベイ

- M.2 SSD 最大2枚 搭載可能

- 10 ギガビット イーサネット 2ポート

- 2U ラックマウントサーバー

- リダンダント電源搭載

製品特長

2Uラックマウントシャーシにインテル® Xeon® 6 6700P/6500P/6700E プロセッサーを2基、2スロットGPUを最大3基搭載するGPGPUモデルです。

「Xeon 6 プロセッサー」はPコア(Performance-core)とEコア(Efficient-core)の2種類のアーキテクチャが採用されています。

「Xeon 6 6700P/6500P」はコアあたりのパフォーマンスに優れたPコアを採用。データセンターや通信事業者などの幅広い環境およびメインストリームのサーバー、エッジ環境に最適です。

「Xeon 6 6700E」は電力効率に優れたEコアを採用し1CPUで最大144コアというコア数を実現。第2世代 Xeonと比較してワットあたりのパフォーマンスは2.6倍となり、同等の性能に必要なラック数は3分の1に集約することで電力の節約、CO2排出量の削減に大幅に貢献します。また、インテル® アドバンスト・ベクトル・エクステンション 2(インテル® AVX2)と、ベクトル・ニューラル・ネットワーク命令(VNNI)やBF16/FP16用の高速変換といった新しい拡張機能により、AI推論とベクトル指向の演算処理に適応します。

インテル® Xeon® 6 プロセッサー 搭載

インテル® Xeon® 6 プロセッサー

「インテル® Xeon® 6 プロセッサー」は「第5世代 Xeon スケーラブル・プロセッサー」の直接の後継となる新しいデータセンター向けプロセッサーです。

従来の「世代名+スケーラブル」の名称を廃止し、Xeonの後に世代名を意味する数字をナンバリングした「Xeon 6 プロセッサ」へリブランドされました。

「インテル® Xeon® 6 プロセッサー」は、ビックデータの解析や設計業務、AIの学習と推論向けにコアごとのパフォーマンスを最適化したPコア(Performance-core 開発コードネーム:Granite Rapids)、クラウドサービスや高密度のワークロード向けにワットパフォーマンスを最適化したEコア(Efficient-core 開発コードネーム:Sierra Forest)の2種類のアーキテクチャが採用されています。また、パッケージも「Xeon 6 6900シリーズ」に使用される大型のLGA7529と、「Xeon 6 6700シリーズ」で使用される比較的小型のLGA4710の2種類が用意されており、「インテル® Xeon® 6 プロセッサー」には2種類のCPUコアと、2種類のCPUソケットがラインナップされていることになります。

| ワークロード | Performane-core コアあたりのパフォーマンスを最適化 |

Efficient-core ワットあたりのパフォーマンスを最適化 |

|---|---|---|

| HPC | ||

| モデル化 & シミュレーション | ||

| CAE | ||

| ウェブ & マイクロサービス | ||

| クラウド専用 | ||

| 消費者向け デジタルサービス |

||

| アプリケーション Dev Ops | ||

| データベース & 分析 | ||

| CRM, ERP | ||

| ビッグデータ | ||

| インメモリー分析 | ||

| 非構造化 データベース |

||

| スケールアウト分析 | ||

| AI | ||

| 生成AI | ||

| ディープラーニング / マシンラーニング |

||

| 推論 | ||

| インフラストラクチャー & ストレージ | ||

| HCI | ||

| 仮想化 | ||

| ストレージ | ||

| ネットワーキング | ||

| CDN | ||

| メディア & ゲーミング | ||

| ネットワーク ・ マイクロサービス |

||

| クラウドネイティブ CDN |

||

| 5G コア | ||

| エッジ | ||

| ビデオ | ||

| エッジ分析 | ||

| 仮想保護リレー | ||

2種類のCPUコアと、2種類のCPUソケット

「Xeon 6 6900P/6700P/6500P」はパフォーマンスに優れたPコアを採用した高性能コアを搭載し、幅広いワークロードで高いAIパフォーマンスを発揮します。6900シリーズは他のシリーズよりもコア数、メモリー・チャンネル数、I/Oレーン数が多く、熱設計電力(TDP)が高くなっています。

また、従来のDDR5-6400 RDIMMだけでなく同容量でより高いメモリバンド幅を持つMRDIMMにも対応し、最大8800MT/sの転送レートでの利用が可能になります。

「Xeon 6 6900E/6700E」は電力効率に優れたEコアを高密度に搭載。1CPUで最大288コアというコア数を実現し、タスク並列の高スループットを必要とするクラウドスケールのワークロードに明確な優位性をもたらします。また、第2世代 Xeonと比較して2.6倍の電力効率を発揮し、同等の性能に必要なラック数を3分の1に集約することが可能です。

|

|

|

|||

|---|---|---|---|---|

| 製品名 | 6900P | 6900E | 6700P/6500P | 6700E |

| 開発コードネーム | Granite Rapids | Sierra Forest | Granite Rapids | Sierra Forest |

| パッケージ | LGA7529 | LGA4710 | ||

| CPUコア | Pコア(高性能コア) | Eコア(高効率コア) | Pコア(高性能コア) | Eコア(高効率コア) |

| 最大コア数 | 128 | 288 | 86 | 144 |

| マルチスレッド | YES | N/A | YES | N/A |

| 対応ソケット数 | 1,2 | 1,2,4,8 | 1,2 | |

| 最大TDP | 500W | 350W | 330W | |

| メモリチャネル | 12チャネル | 8チャネル | ||

| MRDIMM対応 | YES | N/A | YES | N/A |

| 対応メモリ | DDR5-8800 MRDIMM DDR5-6400 RDIMM |

DDR5-6400 RDIMM | DDR5-8000 MRDIMM DDR5-6400 RDIMM |

DDR5-6400 RDIMM |

| PCIe/CXL | PCIe 5.0 96レーン CXL 2.0 |

PCIe 5.0 88レーン *1S=最大136レーン CXL 2.0 |

||

| UPI 2.0 リンク | 6 | 4 | ||

| UPI 速度 | 24GT/s | 24GT/s | ||

| インテル® Xeon® 6 シリーズ | 対象の導入環境 |

|---|---|

| 6900シリーズ | クラウド、AI、HPCなど、極めて負荷の高い環境に最適な最大レベルのパフォーマンス |

| 6700シリーズ | データセンターや通信事業者など幅広い環境に最適な機能拡張されたパフォーマンス |

| 6500シリーズ | メインストリームのサーバーやエッジの環境に最適な基本のパフォーマンス |

| 6300シリーズ | 中小規模のビジネス環境に最適なエントリーレベルのパフォーマンス |

| インテル® Xeon® 6 | P-core採用 | E-core採用 |

|---|---|---|

6900シリーズ最大パフォーマンス 新たなクラスのサーバー・プラットフォーム設計として展開される、クラウド・コンピューティング、AI、HPC、SaaS、IaaSのワークロードに最適なプロセッサー・シリーズ |

|

|

6700/6500シリーズ拡張されたパフォーマンス 確立されたインテルのサーバー・プラットフォーム設計を大幅にアップグレード。エンタープライズIT、デジタル・サービス・プロバイダー、通信事業者のエッジからクラウドまでメインストリームのサーバーに実装。AI、HPC、ネットワーキング、メディア、データサービス、インフラストラクチャー、ストレージ、ウェブ、アプリケーション、マイクロサービスなど、幅広い用途に最適。 |

|

|

インテル® Xeon® 6 プロセッサー 一覧

関連製品

NVIDIA データセンターGPU Ada Lovelace世代 搭載可能

NVIDIA Ada Lovelace

|

販売終了 |

|

|

|---|---|---|---|

| GPUメモリ | 48GB GDDR6 ECC付き | 48GB GDDR6 ECC付き | 24GB GDDR6 ECC付き |

| メモリー帯域幅 | 864GB/s | 864GB/s | 300GB/s |

| インターコネクト インタフェース | PCIe Gen4x16: 64GB/s 双方向 | PCIe Gen4x16: 64GB/s 双方向 | PCIe Gen4x16: 64GB/s |

| CUDA コア数 | 18,176 | 18,176 | 7,424 |

| NVIDIA 第3世代 RT コア | 142 | 142 | 58 |

| NVIDIA 第4世代 Tensor コア | 568 | 568 | 232 |

| RT コア 性能 TFLOPS | 212 | 209 | – |

| FP32 TFLOPS | 91.6 | 90.5 | 30.3 |

| TF32 Tensor コア TFLOPS | 183 | 366 | 90.5 | 181 | 120 |

| BFLOAT16 Tensor コア TFLOPS | 362.05 | 733 | 181.05 | 362.1 | 242 |

| FP16 Tensor コア | 362.05 | 733 | 181.05 | 362.1 | 242 |

| FP8 Tensor コア | 733 | 1466 | 362 | 724 | 485 |

| ピーク INT8 Tensor TOPS | 733 | 1466 | 362 | 724 | 485 |

| ピーク INT4 Tensor TOPS | 733 | 1466 | 724 | 1448 | – |

| 最大消費電力 | 350W | 300W | 72W |

| フォームファクター | 4.4” (H) x 10.5” (L) 2スロット |

4.4” (H) x 10.5” (L) 2スロット |

ロープロファイル 1スロット |

| 排熱機構 | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) |

| ディスプレイポート | 4 x DisplayPort 1.4a | 4 x DisplayPort 1.4a | N/A |

| マルチインスタンスGPU | N/A | N/A | N/A |

| NVLink | N/A | N/A | N/A |

NVIDIA Ada Lovelace アーキテクチャ

Ada GPU アーキテクチャは、レイ トレーシングと AI ベースのニューラル グラフィックスに革新的な性能を実現できるように設計されています。GPU 性能のベースラインが劇的に上がり、レイ トレーシングとニューラル グラフィックスの転換点となります。

CUDA® コア

Transformer Engine

単精度浮動小数点 (FP32) スループットの高速化と電力効率の向上により、3D モデル開発や CAE シミュレーションなどのワークフローでパフォーマンスが大幅に向上します。混合精度ワークロード向けの拡張 16 ビット数学機能 (BF16) をサポート。

第 3 世代 RT コア

スループットとコンカレント レイ トレーシングとシェーディング機能が強化され、レイ トレーシングのパフォーマンスが向上し、製品の設計/アーキテクチャ、エンジニアリング、建設のワークフローのレンダリングが高速化します。ハードウェアでモーション ブラーを高速化し、驚異的なリアルタイム アニメーションを実現する実物のようなデザインをご覧ください。

第 4 世代 Tensor コア

構造的なスパース性と最適化された TF32 形式のハードウェア サポートにより、すぐにパフォーマンスが向上し、AI とデータ サイエンス のモデル トレーニングが高速化します。DLSS を含む AI により強化されたグラフィックス機能を加速させ、選ばれたアプリケーションで優れたパフォーマンスで高解像度を実現します。

48GB の GPU メモリ

48GB の超高速 GDDR6 メモリで、データ サイエンス、シミュレーション、3D モデリング、レンダリングなどの、メモリ負荷の高いアプリケーションやワークロードに対応します。vGPU ソフトウェアを使用して複数のユーザーにメモリを割り当て、クリエイティブ チーム、データ サイエンス チーム、デザイン チーム間で大規模なワークロードを分散します。

仮想化対応

NVIDIA 仮想 GPU (vGPU) ソフトウェア を活用した次世代の改善により、リモート ユーザーがより大規模かつパワフルな仮想ワークステーションのインスタンスを使用できるようになり、高度なデザイン、AI、計算処理におけるより大規模なワークフローが可能になります。

PCI Express Gen 4

PCI Express Gen 4 対応により、PCIe Gen 3 の 2 倍の帯域幅を提供することで、AI やデータサイエンスなどのデータ集約型タスク向けに CPU メモリからのデータ転送速度が向上します。

データ センターの効率性とセキュリティ

NVIDIA L40 は、24 時間 365 日稼動のエンタープライズ データ センター運用に最適化されており、最大限のパフォーマンス、耐久性、アップタイムを確保するために、NVIDIA によって設計、構築、広範囲にテスト、サポートされています。受動冷却、フルハイト フルレングス (FHFL)、デュアルスロット デザイン、最大 300W のボード電力などの特徴を備え、主要な OEM ベンダーのさまざまな筐体構成に収まります。最新のデータ センター標準を満たし、NEBS レベル 3 に対応し、Root of Trust 技術によるセキュア ブートを備え、データ センターにさらなるセキュリティ層を提供します。

関連製品

NVIDIA データセンターGPU Ampere世代 搭載可能

NVIDIA Ampere

販売終了 |

販売終了 |

販売終了 |

|

|

|

|

|---|---|---|---|---|---|---|

| GPUメモリ | 80GB HBM2e | 48GB GDDR6 | 24GB HBM2 | 4x 16GB GDDR6 | 24GB GDDR6 | 16GB GDDR6 |

| メモリー帯域幅 | 1,935GB/s | 696GB/s | 933GB/s | 200GB/s | 600GB/s | 200GB/s |

| 最大消費電力 | 300W | 300W | 165W | 250W | 150W | 40W-60W(初期設定60W) |

| マルチインスタンスGPU | 最大7GPU | N/A | 4GPU 6GB 2GPU 12GB 1GPU 24GB |

N/A | N/A | N/A |

| フォームファクター | PCIe 2スロット |

2スロット FHFL |

2スロット FHFL |

2スロット FHFL |

1スロット FHFL |

1スロット LP |

| NVLink | NVIDIA NVLink 600 GB/s

PCIe Gen4 64 GB/s |

2 ウェイ ロー プロファイル (2 スロット) |

NVIDIA NVLink 200 GB/s

PCIe Gen4 64 GB/s |

N/A | N/A | N/A |

| 排熱機構 | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) |

| FP64(TFLOPS) | 9.7 | 0.58464 | 5.2 | 4x 0.00702 | – | 0.11702 |

| FP64 Tensorコア(TFLOPS) | 19.5 | – | 10.3 | – | – | – |

| Tensor Float 32(TFLOPS) | 156 / 312 | 74.8 / 149.6 | 82 / 165 | 4×9 / 4x 18 | 62.5 / 125 | 9 / 18 |

| BFLOAT16 Tensorコア(TFLOPS) | 312 / 624 | 149.7 / 299.4 | 165 / 330 | 4x 17.9 / 4x 35.9 | 125 / 250 | 18 / 36 |

| FP16 Tensorコア(TFLOPS) | 312 / 624 | 149.7 / 299.4 | 165 / 330 | 4x 17.9 / 4x 35.9 | 125 / 250 | 18 / 36 |

| INT8 Tensorコア(TOPS) | 624 / 1248 | 299.3 / 598.6 | 330 / 661 | 4×35.9 / 4x 71.8 | 250 / 500 | 36 / 72 |

| 実アプリ性能 | 90% | – | – | – | – | – |

NVIDIA Ampere アーキテクチャ

NVIDIA A100 Tensorコア GPUはあらゆる規模で前例のない高速化を実現し、世界最高のパフォーマンスを誇るエラスティック データ センターにAI、データ分析、HPCのためのパワーを与えます。NVIDIA Ampereアーキテクチャで設計されたNVIDIA A100は、NVIDIA データ センター プラットフォームのエンジンです。A100は、前世代と比較して最大20倍のパフォーマンスを発揮し、7つのGPUインスタンスに分割して、変化する需要に合わせて動的に調整できます。40GBと80GB のメモリ バージョンで利用可能なA100 80GBは、毎秒2テラバイト (TB/秒)超えの世界最速メモリ帯域幅を実現し、最大級のモデルやデータセットを解決します。

NVIDIA Ampere アーキテクチャのイノベーション

第3世代 Tensorコア

NVIDIA Volta™ アーキテクチャで最初に導入されたNVIDIA Tensorコア テクノロジは、AIに劇的な高速化をもたらしました。トレーニング時間を数週間から数時間に短縮し、推論を大幅に加速します。NVIDIA Ampereアーキテクチャはこのイノベーションを基盤としており、新しい精度である Tensor Float 32 (TF32) と64ビット浮動小数点 (FP64) を導入することで、AI の導入を加速して簡素化し、Tensor コアのパワーを HPC にもたらします。

TF32はFP32と同じように動作しますが、コードを変更しなくても、AIを最大20倍スピードアップします。 NVIDIA Automatic Mixed Precisionを使用すると、研究者はわずか数行のコードを追加するだけで、自動混合精度とFP16でさらに2倍のパフォーマンスを得られます。また、bfloat16、INT8、INT4に対応しているので、NVIDIA Ampere アーキテクチャのTensorコア GPUのTensorコアは、AIのトレーニングと推論の両方に対する、非常に汎用性の高いアクセラレータです。また、TensorコアのパワーをHPCにもたらすA100およびA30 GPUでは、完全なIEEE準拠のFP64精度での行列演算を実行できます。

Multi-Instance GPU (MIG)

あらゆるAIとHPC アプリケーションがアクセラレーションの恩恵を受けることができますが、すべてのアプリケーションがGPUのフル パフォーマンスを必要とするわけではありません。Multi-Instance GPU (MIG) は、 A100とA30 GPU PU でサポートされている機能であり、ワークロードがGPUを共有することを可能にします。MIGを利用すると、各GPUを複数のGPUインスタンスに分割できます。各インスタンスは完全に分離され、ハードウェア レベルで保護され、専用の高帯域幅メモリ、キャッシュ、コンピューティング コアを与えられます。これにより開発者は、大小を問わずあらゆるアプリケーションに対して画期的な高速化を利用できるようになり、サービス品質も保証されます。また、IT管理者は、適切なサイズのGPUアクセラレーションを提供することで利用率を最適化し、ベアメタル環境と仮想化環境の両方ですべてのユーザーとアプリケーションにアクセスを拡張できます。

第3世代の NVLink

アプリケーションをマルチGPUでスケールさせるには、非常に高速にデータを移動させる必要があります。NVIDIA Ampere アーキテクチャの第3世代 NVIDIA® NVLink® は、GPU 間の直接帯域幅を2倍の毎秒600ギガバイト (GB/s) にします。これは、PCIe Gen4の約10倍です。最新世代の NVIDIA NVSwitch™と組み合わせることで、サーバー内のすべてのGPUが完全なNVLinkの速度で相互に通信し、驚くほど高速なデータ転送が可能になります。 NVIDIA DGX™A100と他の主要なコンピューター メーカーのサーバーは、 NVIDIA HGX™ A100ベースボードを介してNVLinkとNVSwitchのテクノロジを活用し、HPCおよびAIのワークロードに優れたスケーラビリティを提供します。

スパース構造

現代のAIネットワークは大きく、数百万、場合によっては数十億のパラメーターを持ち、ますますその規模は拡大しています。これらのパラメーターのすべてが正確な予測や推論に必要なわけではなく、一部のパラメーターをゼロに変換することで、精度を下げることなくモデルを「スパース」にできます。Tensorコアでは、スパースなモデルのパフォーマンスを最大2倍にできます。スパース機能はAI推論で特に効果を発揮しますが、モデルトレーニングのパフォーマンス向上にも利用できます。

第2世代 RTコア

NVIDIA A40のNVIDIA Ampereアーキテクチャの第2世代RTコアは、映画コンテンツのフォトリアルなレンダリング、建築デザインの評価、製品デザインのバーチャル試作品などのワークロードを大幅にスピードアップします。RTコアはまた、レイ トレーシングされたモーション ブラーのレンダリングをスピードアップし、短時間で結果が得られ、ビジュアルの精度が上がります。さらに、レイ トレーシングをシェーディング機能またはノイズ除去機能と共に同時に実行できます。

よりスマートで高速なメモリ

A100は、データセンターでの膨大な量のコンピューティングを可能にします。コンピューティング エンジンを常に完全に活用するために、A100はこのクラスで最大となる毎秒2テラバイト (TB/s) のメモリ帯域幅を備えています。前世代の2倍以上です。さらに、A100は前世代の7倍となる40メガバイト (MB) のレベル2キャッシュを含む、より大きなオンチップ メモリを搭載しており、コンピューティング パフォーマンスを最大限まで引き上げます。

関連製品

NVIDIA RTX™ Ada Lovelace世代 搭載可能

NVIDIA RTX™ Ada世代

|

|

|

|

|

|

|

|---|---|---|---|---|---|---|

| GPUメモリ | 48GB GDDR6 | 32GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| メモリー帯域幅 | 960GB/s | 576GB/s | 432GB/s | 360GB/s | 280GB/s | 224GB/s |

| ECC | Yes | Yes | Yes | Yes | Yes | Yes |

| CUDAコア | 18,176 | 12,800 | 7,680 | 6,144 | 6,144 | 2816 |

| Tensorコア | 568 | 400 | 240 | 192 | 192 | 88 |

| RTコア | 142 | 100 | 60 | 48 | 48 | 22 |

| 単精度性能(TFLOPS) | 91.1 | 65.3 | 39.6 | 26.7 | 19.2 | 12.0 |

| RTコア性能(TFLOPS) | 210.6 | 151.0 | 91.6 | 61.8 | 44.3 | 27.7 |

| Tensor性能(TFLOPS) | 1,457.0 | 1,044.4 | 634.0 | 327.6 | 306.8 | 191.9 |

| NVLink | N / A | N / A | N / A | N / A | N / A | N / A |

| NVLink帯域幅 | N / A | N / A | N / A | N / A | N / A | N / A |

| システムインターフェイス | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x8 |

| 最大消費電力 | 300W | 250W | 210W | 130W | 70W | 70W |

| 排熱機構 | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ |

| フォームファクター | 4.4″ H x 10.5″ L 2スロット |

4.4″ H x 10.5″ L 2スロット |

4.4″ H x 10.5″ L 2スロット |

4.4″ H x 9.5″ L 1スロット |

2.7″ H x 6.6″ L 2スロット |

2.7″ H x 6.6″ L 2スロット |

| 画面出力 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | Mini DisplayPort 1.4a x4 | Mini DisplayPort 1.4a x4 |

NVIDIA Ada Lovelace アーキテクチャ

NVIDIA RTX™ Ada 世代は、現代のプロフェッショナル ワークフローの課題に対応する特徴、機能、パフォーマンスを提供します。NVIDIA Ada Lovelace アーキテクチャで構築された RTX 6000 は、第 3 世代の RT コア、第 4 世代の Tensor コア、次世代 CUDA® コアを 48GB のグラフィックス メモリを組み合わせ、かつてないレンダリング、AI グラフィックス、コンピューティング パフォーマンスを実現します。NVIDIA RTX 6000 搭載ワークステーションは、今日の非常に困難なビジネス環境で成功するために必要なものを提供します。

中心となるテクノロジ

NVIDIA CUDA コア

単精度浮動小数点 (FP32) 演算の倍速処理により、デスクトップにおける複雑な 3D のコンピューター支援設計 (CAD) とコンピューター支援エンジニアリング (CAE) などのグラフィックスやシミュレーションのワークフローに適した驚異的なパフォーマンス向上を実現します。

第 3 世代 RT コア

前世代と比較して最大 2 倍のスループットを備えた第 3 世代 RT コアにより、動画コンテンツのフォトリアルなレンダリング、建築デザインの評価、製品デザインの仮想プロトタイプなどのワークロードのための圧倒的な高速化を実現します。このテクノロジにより、レイ トレーシングによるモーション ブラー レンダリングをより高いビジュアル精度で高速化することができます。

第 4 世代 Tensor コア

第 4 世代の Tensor コアは、より高速な AI コンピューティング パフォーマンスを提供し、前世代の 2 倍以上のパフォーマンスを実現します。これらの新しい Tensor コアは、FP8 精度データ型の高速化をサポートし、独立した浮動小数点と整数のデータ パスを提供し、浮動小数点と整数を混合した計算の実行を高速化します。

48GB GPU メモリ

48GB GDDR6 メモリを搭載した RTX 6000 は、データ サイエンティスト、エンジニア、クリエイティブなプロフェッショナル向けに、レンダリング、データ サイエンス、シミュレーションなどの膨大なデータセットやワークロードを使用する作業に必要な大容量メモリを提供します。

仮想化対応

NVIDIA RTX 仮想ワークステーション (vWS) ソフトウェアをサポートすることで、個人のワークステーションを複数のハイパフォーマンスな仮想ワークステーション インスタンスとして使用できるため、リモートのユーザーがリソースを共有して、ハイエンドのデザイン、AI、コンピューティングのワークロードを進めることができます。

PCIe Gen 4

PCI Express Gen 4 対応により、PCIe Gen 3 の 2 倍の帯域幅を提供することで、AI やデータ サイエンスなどのデータ集約型タスク向けに CPU メモリからのデータ転送速度が向上します。

関連製品

製品仕様

| CPU |

インテル Xeon 6 6700P プロセッサー

x 2

or インテル Xeon 6 6700P プロセッサーor インテル Xeon 6 6500P プロセッサーインテル Xeon 6 6700E プロセッサー |

|---|---|

| チップセット | System on Chip ( SoC ) |

| メモリ | DDR5-6400MHz ECC RDIMM x 32 |

| ドライブベイ | 2.5インチ ホットスワップ ( NVMe 対応 ) x 8

or 2.5インチ ホットスワップ ( SATA / SAS 対応 ) x 8 オプション |

| M.2スロット | インターフェイス : PCI-Express 4.0 x2 ( NVMe 対応 ) フォームファクタ : 2260/2280 x 2 |

| オプティカルドライブ | USB接続 外付けDVDマルチドライブ オプション |

| グラフィックス | オンボード |

| GPU | 2スロット GPU 最大 x 3 |

| ネットワークI/F | 10ギガビット イーサネット ( RJ45 ) x 2 |

| 管理I/F | BMC / IPMI 2.0 |

| I/Oポート 前面 | USB3.2 Gen1 x 2 |

| I/Oポート 背面 | Mini-DP x 1

USB3.2 Gen1 x 2 IPMI用 MLAN ( RJ45 ) x 1 |

| 拡張スロット | PCI Express 5.0 x16 ( FHFL ) x 3 or PCI Express 5.0 x8 ( FHFL ) x 6 オプション

PCI Express 5.0 x16 ( FHHL ) x 2 PCI Express 5.0 x16 ( OCP3.0 ) x 1 PCI Express 5.0 x8 ( OCP3.0 ) x 1 |

| ケース | 2Uラックマウントケース : W 449mm x H 88mm x D 830mm |

| 電源 | 100V 1500W / 200V 2800W x2 (1+1) リダンダント電源 80-plus Titanium |

| OS |

|

| 保守 | 1年間全国出張オンサイトサービス 3年間全国出張オンサイト オプション |

| 動作推奨環境 | 温度 : 10 ℃ ~ 35 ℃ 湿度 : 20 % ~ 80 % (結露なきこと) |

カタログ

商標について

- Intel、インテル、Intel ロゴ、Intel Inside、Intel Inside ロゴ、Intel Atom、Intel Atom Inside、Intel Core、Core Inside、Intel vPro、vPro Inside、Celeron、Celeron Inside、Itanium、Itanium Inside、Pentium、Pentium Inside、Xeon、Xeon Phi、Xeon Inside、Ultrabook は、アメリカ合衆国および/またはその他の国におけるIntel Corporation の商標です。

- AMD、AMD EPYC™、AMD Ryzen™ 、AMD Radeon™ 、Radeon Instinct™ は、アメリカ合衆国および/またはその他の国におけるAdvanced Micro Devices,Incの商標です。

- NVIDIA、NVIDIA のロゴ、GeForce、 CUDA、 NVLINK、SLI、Tesla、Quadro、および SHIELD は、米国またはその他の国における NVIDIA Corporation の商標または登録商標です

- Supermicroは商標であり、米国のSuper Micro Computer, Inc.およびその他の国における子会社の登録商標です。

- Red Hat、Red Hat Enterprise Linux、Shadowmanロゴ、JBossは米国およびその他の国において登録されたRed Hat, Inc.の商標です。

- Linux(R)は米国およびその他の国におけるLinus Torvaldsの登録商標です。

- SUSEおよびSUSEロゴは、米国およびその他の国におけるSUSE LLCの登録商標です。

- VMwareおよびVMwareの製品名は、VMware, Inc.の米国および各国での商標または登録商標です。

- Microsoft、Windows、MS-DOS、Windows NT、Windows Vista、Windows Server、Windows Azure、SQL Serverおよび Microsoft Exchange Serverまたはその他のマイクロソフト製品の名称および製品名は、米国 Microsoft Corporation の、米国およびその他の国における商標または登録商標です。

- UNIXは、米国およびその他の国におけるオープン・グループの登録商標です。

- その他弊社ウェブサイト(本サイト)に表示・記載されている会社名、製品名およびロゴ等は、各社の登録商標または商標です。