販売終了 |

販売終了 |

|

|---|---|---|

| FP64(TFLOPS) | 68 | 26 |

| FP64 Tensor コア(TFLOPS) | 134 | 51 |

| FP32(TFLOPS) | 134 | 51 |

| TF32 Tensor コア(TFLOPS) | 1,979 | 756 |

| BFLOAT16 Tensorコア(TFLOPS) | 3,958 | 1,513 |

| FP16 Tensorコア(TFLOPS) | 3,958 | 1,513 |

| FP8 Tensorコア(TFLOPS) | 7,916 | 3,026 |

| INT8 Tensorコア(TOPS) | 7,916 | 3,026 |

| GPUメモリ | 188GB | 80GB |

| GPUメモリー帯域幅 | 7.8TB/s | 2TB/s |

| デコーダー | 14 NVDEC 14 JPEG |

7 NVDEC 7 JPEG |

| 最大消費電力 | 2x 350-400W(構成可能) | 300-350W(構成可能) |

| マルチインスタンスGPU | 最大14GPU MIG@12GB | 最大7GPU MIG@10GB |

| フォームファクター | 2x PCIe 2スロット |

PCIe 2スロット |

| 相互接続 | NVIDIA NVLink 600 GB/s PCIe Gen5 128 GB/s |

NVIDIA NVLink 600 GB/s PCIe Gen5 128 GB/s |

| NVIDIA AI Enterprise | 含む | 含む |

| 排熱機構 | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) |

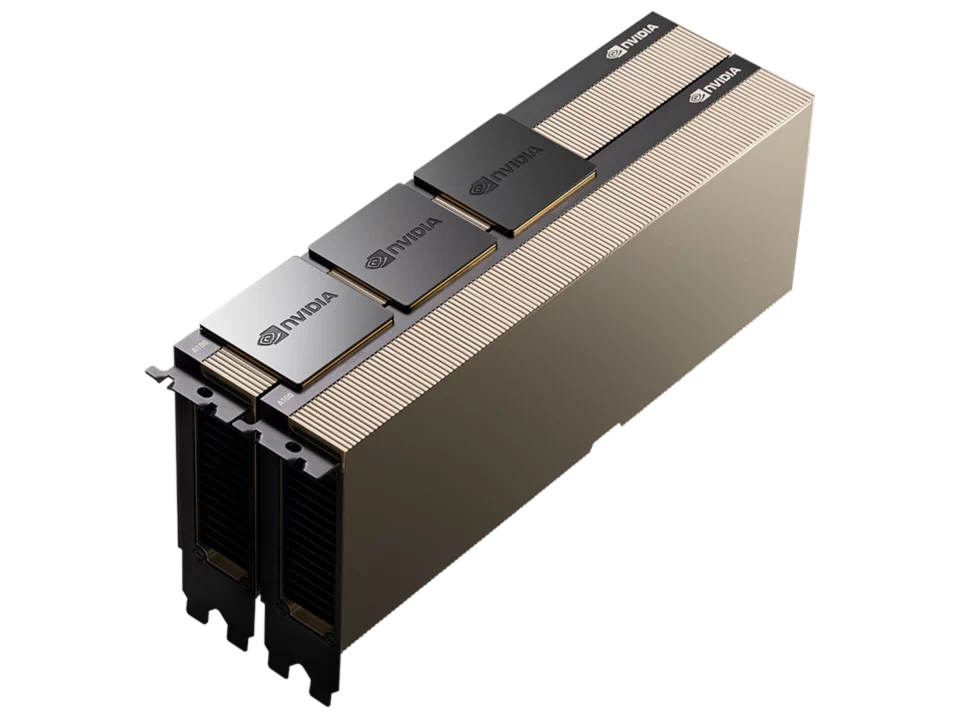

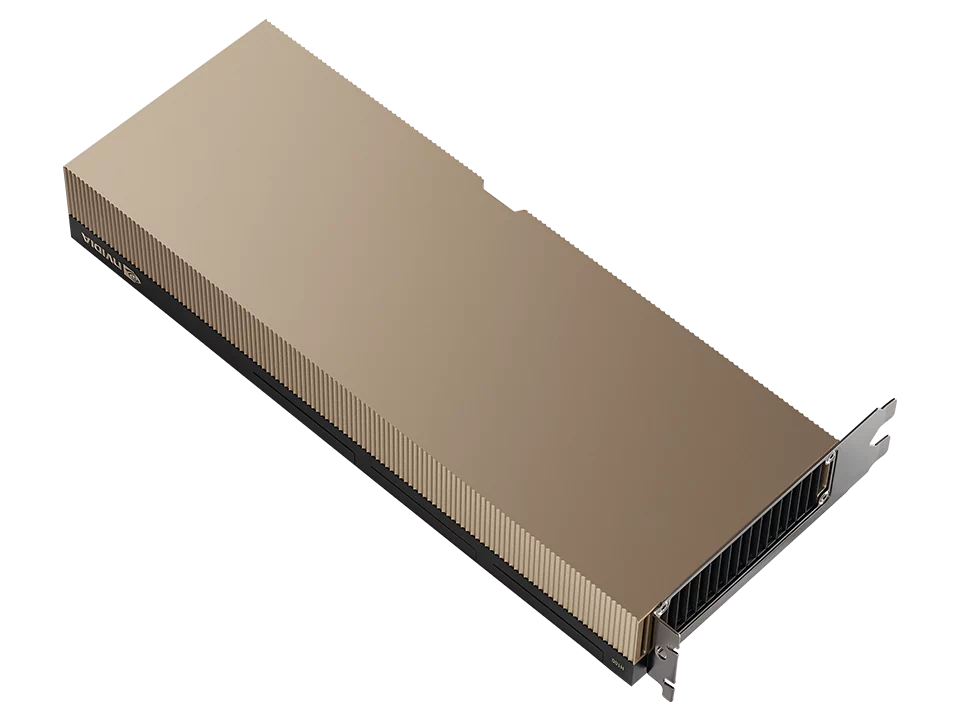

大規模AI向けGPU「NVIDIA H100 NVL」

「NVIDIA H100 NVL」は1基あたり94GBのメモリを搭載しており、2基の「NVIDIA H100 NVL」をNVLinkで接続することにより188GBもの大容量メモリと7.8TB/秒のメモリ帯域を実現。

ChatGPTのように大量のデータを展開する必要があるLLM (大規模言語モデル)や生成AIの推論に最適化され、GPT-3では前世代のA100と比較して最大12倍高速な推論パフォーマンスをデータセンター規模で提供します。

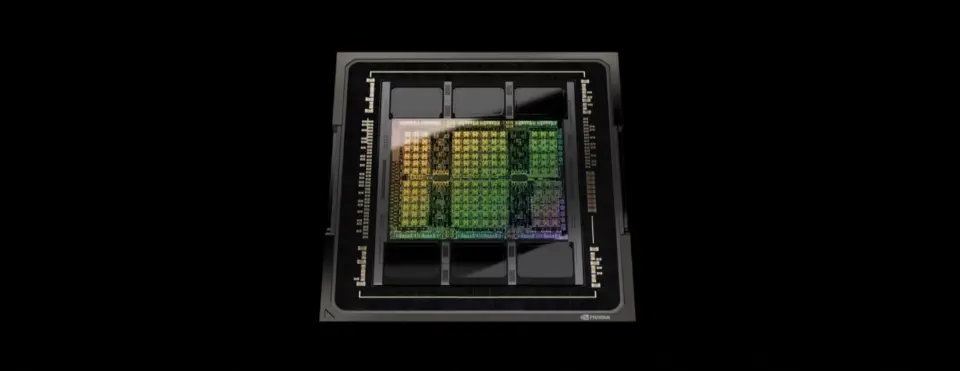

NVIDIA Hopper™ アーキテクチャ

最新の TSMC 4N プロセスを利用し、800 億個以上のトランジスタで作られた Hopper は、NVIDIA H100 Tensor コア GPU の中核をなす 5 つの画期的なイノベーションを持ち、それにより世界最大の言語生成モデルである NVIDIA の Megatron 530B チャットボットの AI 推論で、前世代と比較して 30 倍という驚異的なスピードアップを実現します。

NVIDIA Hopper™ アーキテクチャのイノベーション

Transformer Engine

NVIDIA Hopper™ アーキテクチャは、AI モデルのトレーニングを高速化するように設計された Transformer Engine との組み合わせで Tensor コア テクノロジを前進させます。Hopper Tensor コアでは FP8 と FP16 の精度を混在させることができます。トランスフォーマーの AI 計算が劇的に速くなります。Hopper はまた、TF32、FP64、FP16、INT8 の精度の浮動小数点演算 (FLOPS) を前世代の 3 倍にします。Transformer Engine と第 4 世代 NVIDIA® NVLink® と組み合わせることで Hopper Tensor コアは HPC と AI のワークロードを桁違いに高速化します。

NVLink Switch システム

ビジネスの最先端では、エクサスケール HPC と兆パラメーター AI モデルを大規模にスケールするために、サーバークラスター内の各 GPU 間に高速でシームレスな通信が必要です。 第 4 世代 NVLink は、スケールアップ相互接続です。新しい外部 NVLink Switch と組み合わせると、NVLink Switch システムは、PCIe Gen5 の 7 倍以上の帯域幅である、GPU あたり 900 ギガバイト/秒 (GB/s) の双方向で複数のサーバーにわたるマルチ GPU IO (入出力) を拡張することが可能になりました。NVLink Switch システムは、最大 256 基の H100 を接続したクラスターをサポートし、Ampere で InfiniBand HDRの 9 倍高い帯域幅を実現します。

さらに、NVLink は、これまで InfiniBand でしか利用できなかった SHARP と呼ばれる In-network Computing をサポートし、57.6 テラバイト/秒 (TB/s) の All-to-All の帯域幅を実現しながら、FP8 スパース AI コンピューティングで 1 exaFLOPS という驚くべき性能を提供することができるようになりました。

NVIDIA コンフィデンシャル コンピューティング

データはストレージに保存されているときと、ネットワーク間を転送されるときは暗号化されますが、処理中は保護が解除されます。この保護のない時間に対処するのが NVIDIA コンフィデンシャル コンピューティングです。使用中のデータとアプリケーションを保護します。NVIDIA Hopper™ アーキテクチャは、コンフィデンシャル コンピューティング機能を持った世界初のアクセラレーテッド コンピューティング プラットフォームを導入するものです。

ハードウェアベースの強力なセキュリティを持ち、ユーザーはオンプレミス、クラウド、エッジでアプリケーションを実行できます。許可のないエンティティは使用中のアプリケーション コードやデータを表示することも、変更することもできません。データとアプリケーションの機密性と完全性が守られ、AI トレーニング、AI 推論、HPC ワークロードのかつてない高速化を利用できます。

第 2 世代 MIG

マルチインスタンス GPU (MIG) という機能では GPU を、完全に分離された複数の小さなインスタンスに分割できます。それぞれにメモリ、キャッシュ、コンピューティング コアが与えられます。Hopper アーキテクチャは MIG の機能をさらに強化するものです。最大 7 個の GPU インスタンスで仮想環境のマルチテナント/マルチユーザー構成をサポートします。コンフィデンシャル コンピューティングによってハードウェアおよびハイパーバイザー レベルで各インスタンスが分離されるため、安全です。MIG インスタンスごとに専用のビデオ デコーダーが与えられ、共有インフラストラクチャで安定したハイスループットのインテリジェント ビデオ解析 (IVA) が実現します。そして、Hopper の同時実行 MIG プロファイリングを利用すると、管理者はユーザーのために正しいサイズの GPU 高速化を監視し、リソース割り当てを最適化できます。

研究者のワークロードが比較的少ない場合、完全な CSP インスタンスを借りる代わりに、MIG を利用して GPU の一部を安全に分離することを選択できます。保存中、移動中、処理中のデータが安全なため、安心です。

DPX 命令

動的プログラミングは、複雑な再帰的問題を単純な小問題に分割して解決するアルゴリズム手法です。小問題の結果を格納しておけば、後で再計算する必要がありません。幾何級数的問題の解決にかかる時間が短縮され、その複雑性が緩和されます。動的プログラミングは幅広い使用例で一般的に使用されています。

たとえば、Floyd-Warshall は、出荷車両と配送車両のための最短経路を地図に表示する経路最適化アルゴリズムです。Smith-Waterman アルゴリズムは DNA 配列とタンパク質フォールディングの応用に使用されます。 Hopper の DPX 命令は、従来のデュアル ソケット CPU のみのサーバーと比較して 40 倍、NVIDIA Ampere アーキテクチャ GPU と比較して 7 倍の速さで、動的プログラミング アルゴリズムを加速します。これにより、病気の診断、ルーティングの最適化、さらにはグラフ分析を飛躍的に高速化します。