NVIDIA A100 Tensor Core GPUはAIとHPC用途のためにデータセンター向けGPUとして開発されたVolta世代の後継として製造プロセスルール7nmのAmpereアーキテクチャを採用。第3世代のTensorコアを実装し、BFloat16、Tensor Float 32を新たにサポート、前世代のVoltaと比較しFP32演算、INT8のディープラーニング推論処理において20倍の性能を実現し、トレーニングと推論の両方が強化されています。

また、Multi-instance GPU(MIG)機能により単一のA100を最大7個のGPUとして扱うことが可能で複数のユーザーが独立したインスタンスとして利用できます。

- Ampereアーキテクチャ

- 第3世代Tensorコア

- 第3世代NVLinkとNVSwitch

- 構造的疎性による推論の高速化

- Multi-instance GPU(MIG)機能

- PCI Express Gen 4対応

世界最大のトランジスタ数540億の7nmプロセス チップ

TF32を導入しAI性能が20倍に向上

GPU間を相互に接続するNVLinkは前世代比で2倍のスループレットに向上し600GB/sで接続可能。

「疎行列」(Sparse Matrix)演算への対応と最適化によりAI性能を2倍高速化

単体のA100を最大7つの独立したインスタンスに分割し、複数ユーザーが互いに影響させることなく各自のワークロードを同時に実行できます。

汎用性を高めストレージ、ネットワークを高速化。

|

|

|

|---|---|---|

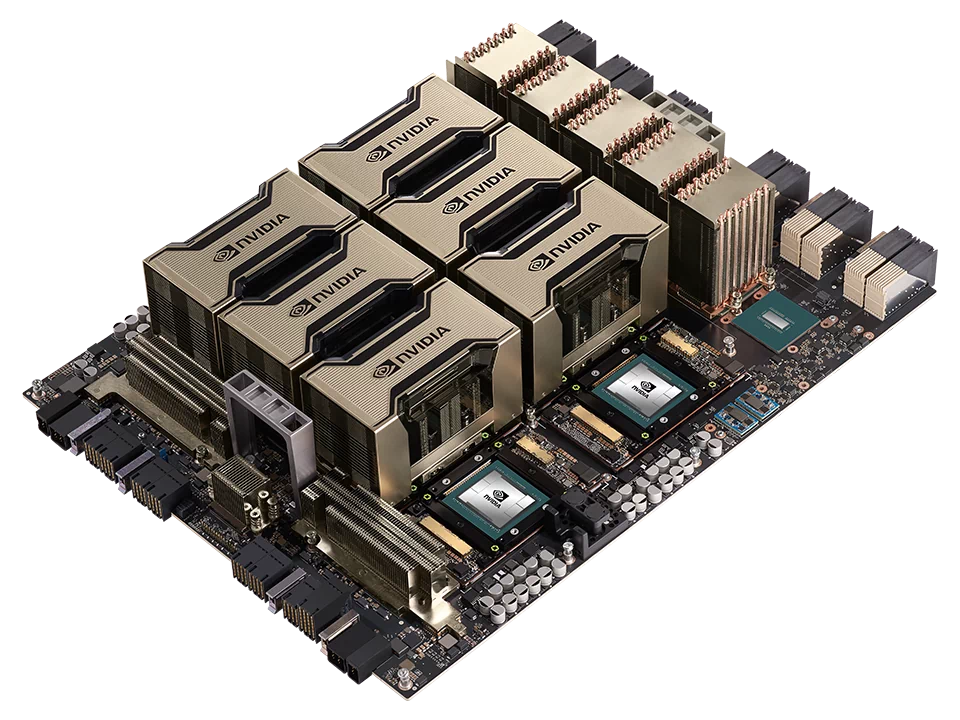

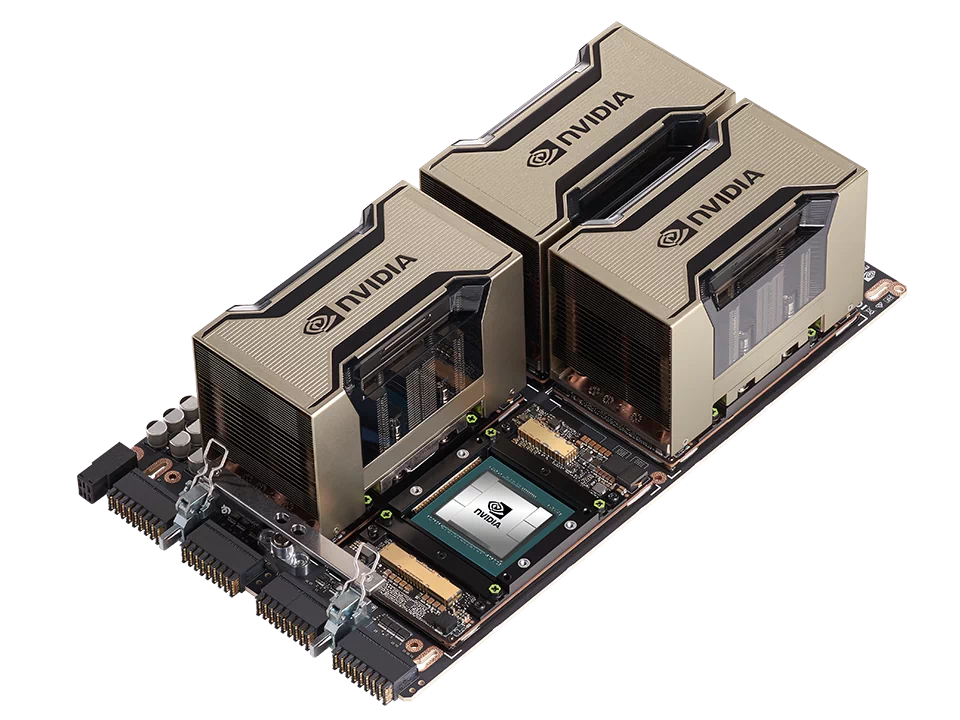

| GPU | HGX A100 8-GPU | HGX A100 4-GPU |

| フォームファクタ | NVIDIA A100 SXM 8基 | NVIDIA A100 SXM 4基 |

| HPC および AI 計算 (FP64/TF32/FP16/FP8/INT8) |

156TF/2.5PF/5PF/10POPS | 78TF/1.25PF/2.5PF/5POPS |

| メモリ | 最大 640 GB | 最大 320 GB |

| NVLink | 第 3 世代 | |

| NVSwitch | 第 2 世代 | N / A |

| GPU 間の帯域幅を備えた NVS | 600 GB/秒 | N / A |

| 合計帯域幅 | 4.8 TB/秒 | 2.4 TB/秒 |