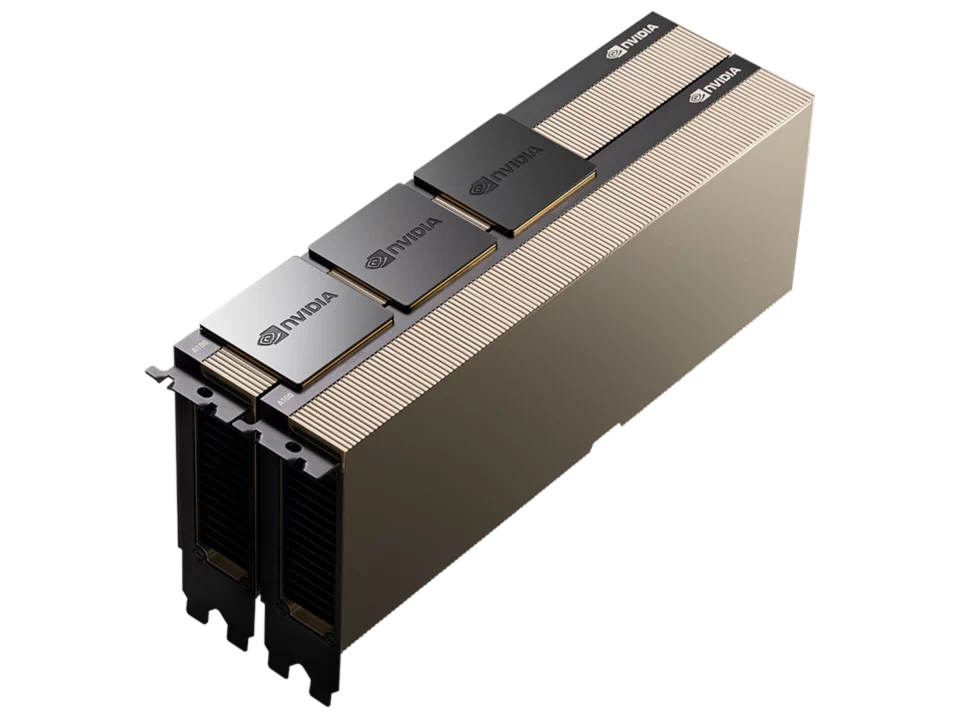

NVIDIA 大規模AI向けGPU「NVIDIA H200 NVL」取り扱い開始

NVIDIA(本社:アメリカ)、NVIDIA Hopper アーキテクチャを採用した大規模AI向けGPU「NVIDIA H200 NVL」の取り扱いを開始いたします。

「NVIDIA H200 NVL」は、柔軟な構成が求められる空冷式エンタープライズラック向けに最適化された低消費電力モデルです。あらゆる規模のAIおよびHPC処理に対応する高い処理性能を実現します。最大4基のGPUをNVIDIA NVLink™で相互接続し、1.5倍のメモリ容量を備えることで、大規模言語モデル(LLM)の推論処理ではH100 NVL比で最大1.7倍、HPC処理では最大1.3倍の性能向上を達成しています。

詳しくは下記よりお問い合わせください。

お問い合わせフォーム

|

|

|---|---|

| FP64(TFLOPS) | 30 |

| FP64 Tensor コア(TFLOPS) | 60 |

| FP32(TFLOPS) | 60 |

| TF32 Tensor コア(TFLOPS) | 835 |

| BFLOAT16 Tensorコア(TFLOPS) | 1,671 |

| FP16 Tensorコア(TFLOPS) | 1,671 |

| FP8 Tensorコア(TFLOPS) | 3,341 |

| INT8 Tensorコア(TOPS) | 3,341 |

| GPUメモリ | 141GB |

| GPUメモリー帯域幅 | 4.8TB/s |

| デコーダー | 7 NVDEC 7 JPEG |

| コンフィデンシャル コンピューティング | サポート対象 |

| 最大熱設計電力(TDP) | 最大600W(設定可能) |

| マルチインスタンスGPU | 最大7パーティション(各16.5GB) |

| フォームファクター | PCIe デュアルスロット空冷 |

| 相互接続 | 2台または4台構成時のNVIDIA NVLink ブジッジ : GPU1台あたり 900 GB/s PCIe Gen5 : 128 GB/s |

| NVIDIA AI Enterprise | 同梱 |

| 排熱機構 | パッシブ(冷却ファンなし) |