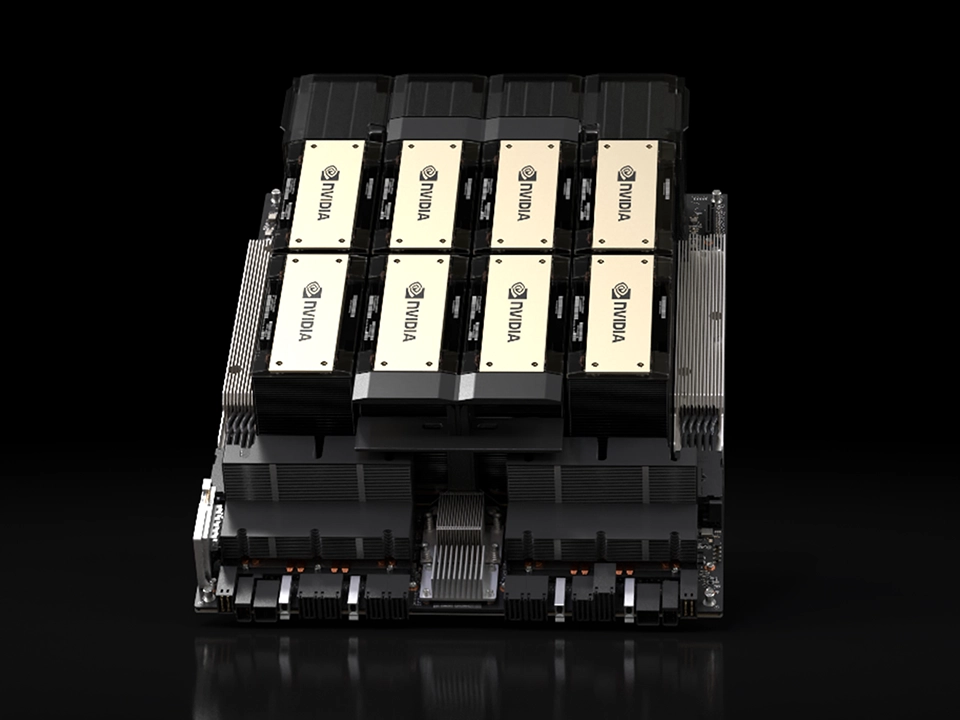

NVIDIA 大規模AI向けGPU「NVIDIA HGX H200」取り扱い開始

NVIDIA(本社:アメリカ)、NVIDIA Hopper アーキテクチャを採用した大規模AI向けGPU「NVIDIA HGX H200」の取り扱いを開始いたします。

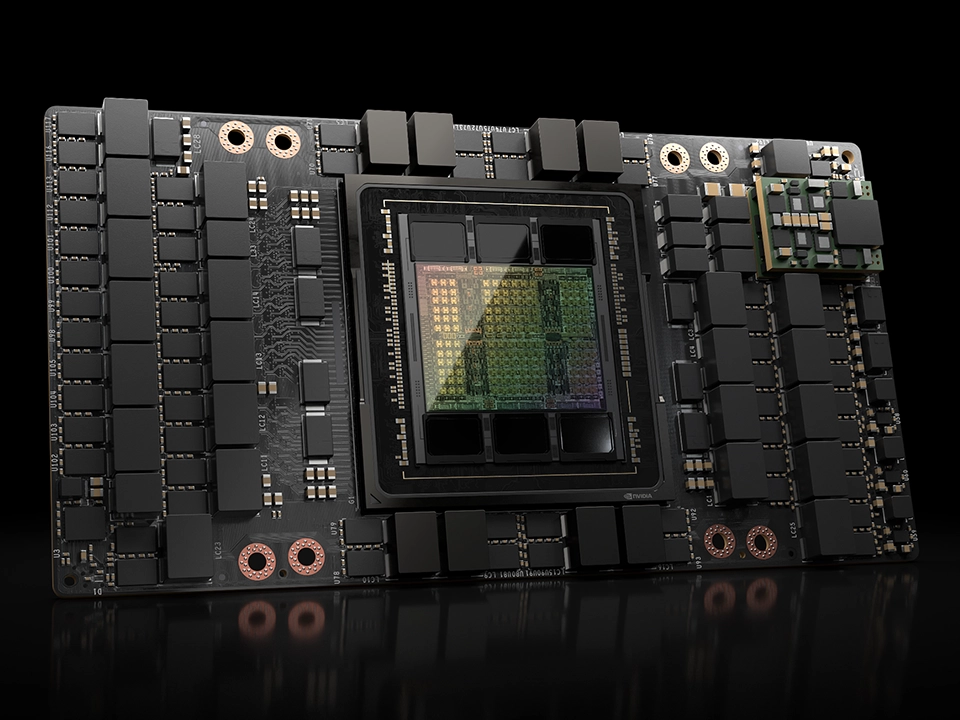

「NVIDIA HGX H200」は、NVIDIA H200 TensorコアGPUと高度なメモリを備え、生成AIやハイパフォーマンス コンピューティング ワークロードのために大量のデータを処理します。

詳しくは下記よりお問い合わせください。

お問い合わせフォーム

|

|

|---|---|

| FP64(TFLOPS) | 34 |

| FP64 Tensor コア(TFLOPS) | 67 |

| FP32(TFLOPS) | 67 |

| TF32 Tensor コア(TFLOPS) | 989 |

| BFLOAT16 Tensorコア(TFLOPS) | 1,979 |

| FP16 Tensorコア(TFLOPS) | 1,979 |

| FP8 Tensorコア(TFLOPS) | 3,958 |

| INT8 Tensorコア(TOPS) | 3,958 |

| GPUメモリ | 141GB |

| GPUメモリー帯域幅 | 4.8TB/s |

| デコーダー | 7 NVDEC 7 JPEG |

| コンフィデンシャル コンピューティング | サポート対象 |

| 最大熱設計電力(TDP) | 最大700W(構成可能) |

| マルチインスタンスGPU | 各18GBで最大7個のMIG |

| フォームファクター | SXM |

| 相互接続 | NVLink : 900 GB/s PCIe Gen5 : 128 GB/s |

| NVIDIA AI Enterprise | アドオン |

| 排熱機構 | パッシブ(冷却ファンなし) |