NVIDIA H100 NVL 最大8基搭載「VCXS-5UDR24L1301-G」を販売開始

NVIDIA(本社:アメリカ)、NVIDIA H100 NVLを最大8基搭載するGPGPU製品「VCXS-5UDR24L1301-G」の販売を開始いたします。

5UラックマウントシャーシにIntel® Xeon スケーラブル・プロセッサーを2基、NVIDIA H100 NVLを最大8基搭載する超高密度GPGPUモデルです。

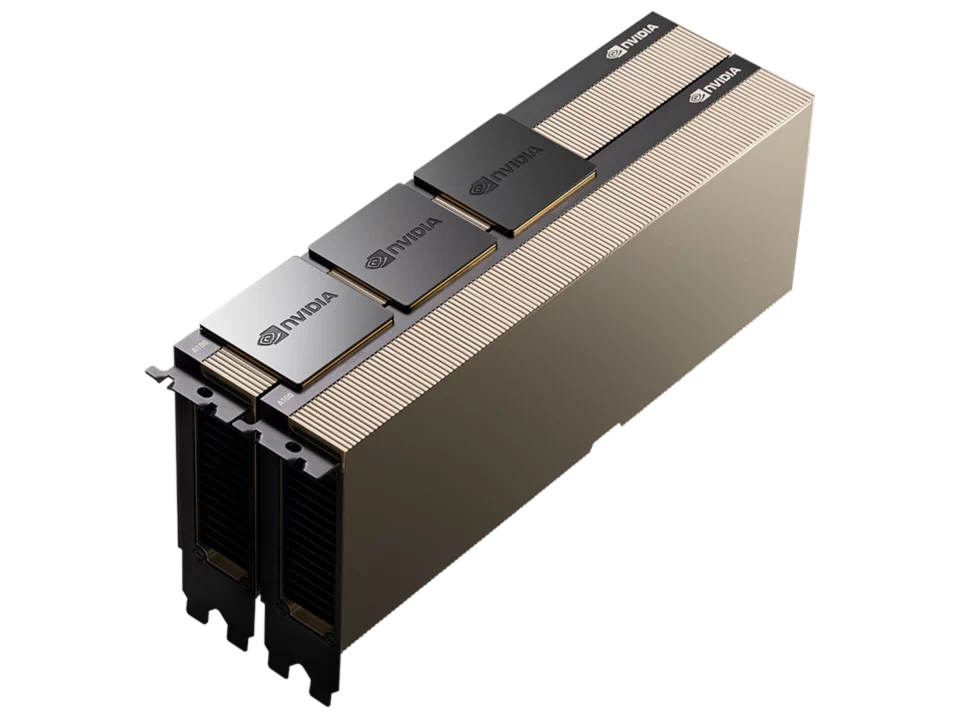

「NVIDIA H100 NVL」は1基あたり94GBのメモリを搭載しており、2基の「NVIDIA H100 NVL」をNVLinkで接続することにより188GBもの大容量メモリと7.8TB/秒のメモリ帯域を実現。

ChatGPTのように大量のデータを展開する必要があるLLM (大規模言語モデル)や生成AIの推論に最適化され、GPT-3では前世代のA100と比較して最大12倍高速な推論パフォーマンスをデータセンター規模で提供します。

主な仕様

- 第5世代 インテル® Xeon® スケーラブル・プロセッサー 2基(Emerald Rapids / LGA4677 )

- DDR5-4800 メモリ 32スロット

- 2スロット PCIe GPU 最大8基 搭載可能

- NVIDIA H100 NVL 搭載可能

- NVIDIA L40S/L40 搭載可能

- NVIDIA データセンター GPU 搭載可能

- 2.5 インチ ホットスワップ 24ベイ

- M.2 SSD 最大2枚 搭載可能

- 10 ギガビット イーサネット 2ポート

- 5U ラックマウントサーバー

- 200V専用 リダンダント電源 4基

製品の詳細は以下の製品ページをご覧下さい。

VCXS-5UDR24L1301-G

|

|

|

|---|---|---|

| FP64(TFLOPS) | 68 | 26 |

| FP64 Tensor コア(TFLOPS) | 134 | 51 |

| FP32(TFLOPS) | 134 | 51 |

| TF32 Tensor コア(TFLOPS) | 1,979 | 756 |

| BFLOAT16 Tensorコア(TFLOPS) | 3,958 | 1,513 |

| FP16 Tensorコア(TFLOPS) | 3,958 | 1,513 |

| FP8 Tensorコア(TFLOPS) | 7,916 | 3,026 |

| INT8 Tensorコア(TOPS) | 7,916 | 3,026 |

| GPUメモリ | 188GB HBM3 | 80GB HBM2e |

| GPUメモリー帯域幅 | 7.8TB/s | 2TB/s |

| デコーダー | 14 NVDEC 14 JPEG |

7 NVDEC 7 JPEG |

| 最大消費電力 | 2x 350-400W(構成可能) | 300-350W(構成可能) |

| マルチインスタンスGPU | 最大14GPU MIG@12GB | 最大7GPU MIG@10GB |

| フォームファクター | 2x PCIe 2スロット |

PCIe 2スロット |

| 相互接続 | NVIDIA NVLink 600 GB/s PCIe Gen5 128 GB/s |

NVIDIA NVLink 600 GB/s PCIe Gen5 128 GB/s |

| NVIDIA AI Enterprise | 含む | 含む |

| 排熱機構 | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) |