- NVIDIA データセンターGPU 搭載製品

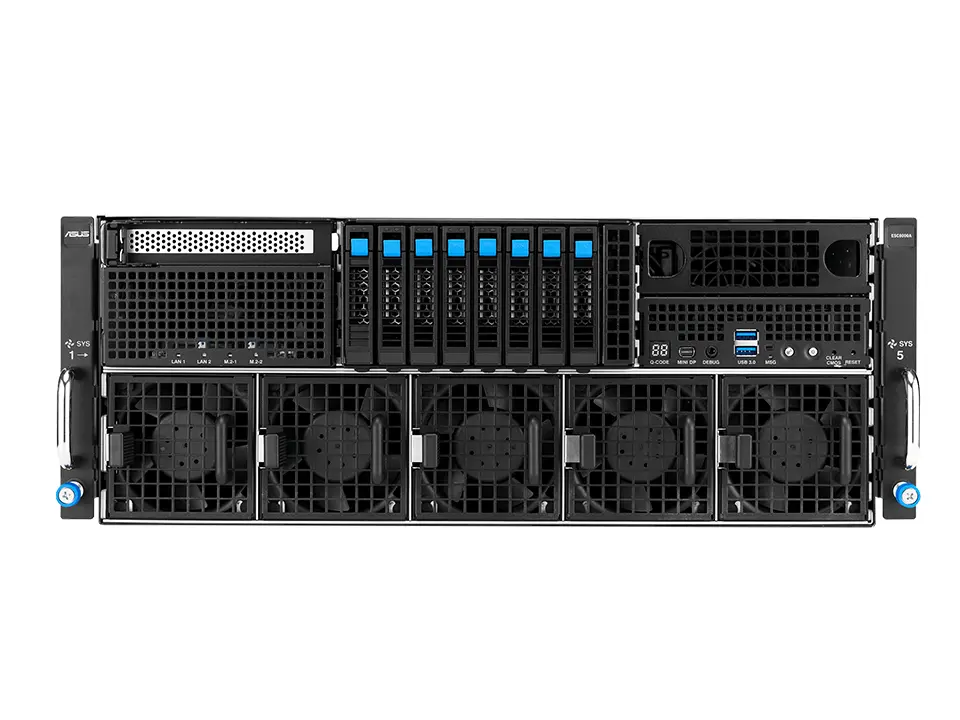

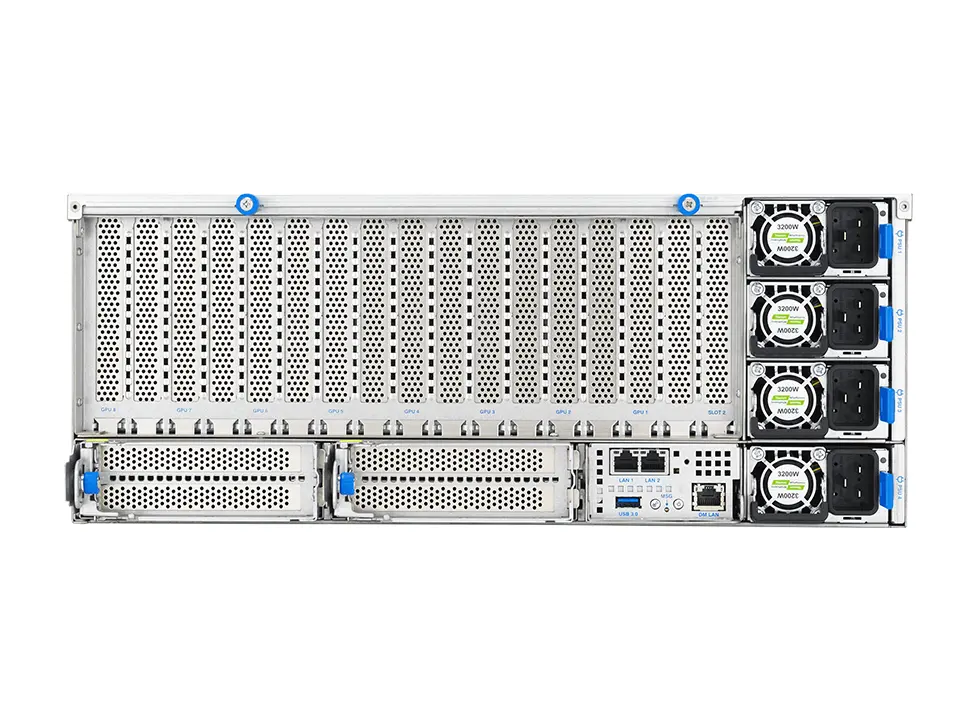

- VCXS-4UDR08L1401-G

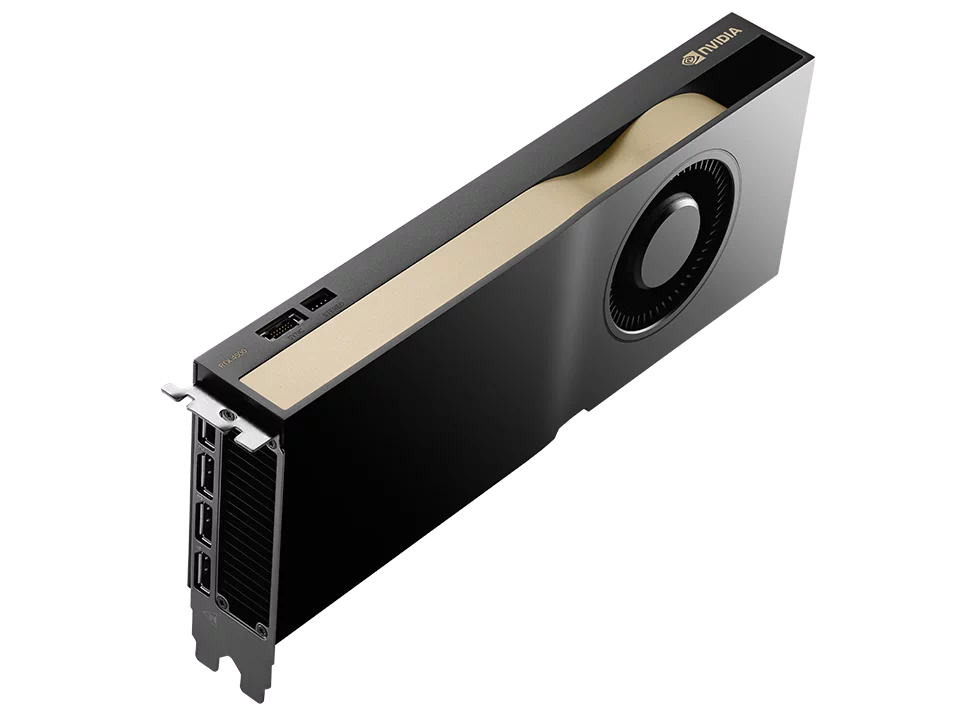

- NVIDIA RTX 搭載製品

- VCXS-4UDR08L1401-G

画像は実際の製品と異なる場合があります。

NVIDIA H200 NVL 最大8基搭載

VCXS-4UDR08L1401-G

2 基

32 枚

8 基

8 ベイ

2 枚

4U

冗長電源

10GbE

主な仕様

- インテル® Xeon® 6 6700P/6500P/6700E プロセッサー 2基

(Granite Rapids,Sierra Forest / LGA4710 ) - DDR5-6400 メモリ 32スロット

- 2スロット PCIe GPU 最大8基 搭載可能

- NVIDIA H200 NVL 搭載可能

- NVIDIA データセンター GPU 搭載可能

- 2.5 インチ ホットスワップ 8ベイ

- M.2 SSD 最大2枚 搭載可能

- 10 ギガビット イーサネット 2ポート

- 4U ラックマウントサーバー

- リダンダント電源搭載

製品特長

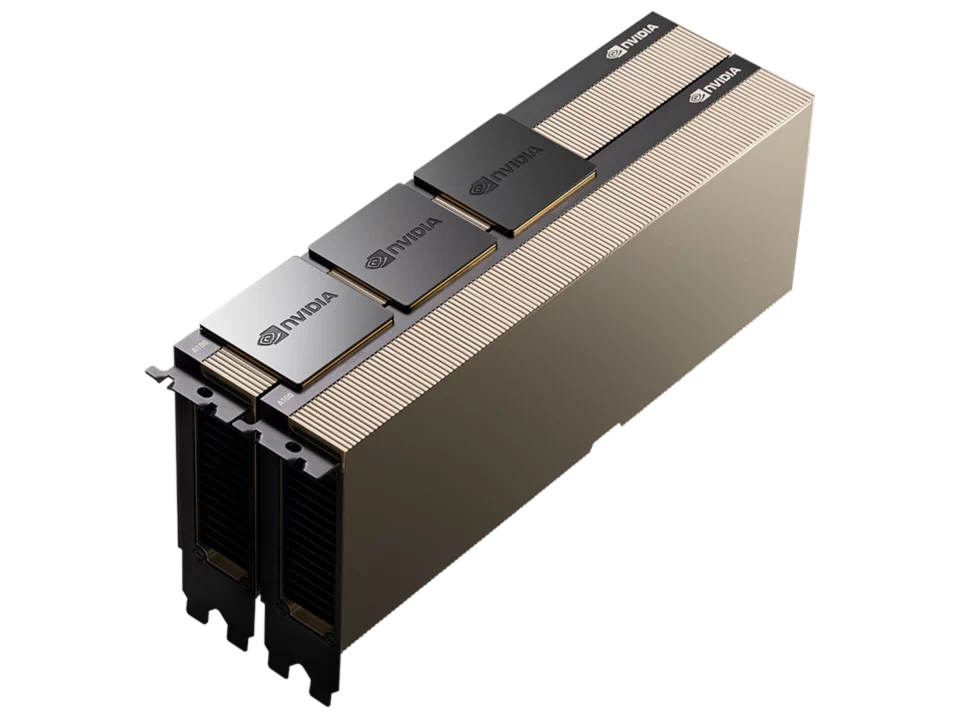

4UラックマウントシャーシにNVIDIA H200 NVLを最大8基搭載する超高密度GPGPUモデルです。

「NVIDIA H200 NVL」は、柔軟な構成が求められる空冷式エンタープライズラック向けに最適化された低消費電力モデルです。あらゆる規模のAIおよびHPC処理に対応する高い処理性能を実現します。最大4基のGPUをNVIDIA NVLink™で相互接続し、1.5倍のメモリ容量を備えることで、大規模言語モデル(LLM)の推論処理ではH100 NVL比で最大1.7倍、HPC処理では最大1.3倍の性能向上を達成しています。

「Xeon 6 プロセッサー」はPコア(Performance-core)とEコア(Efficient-core)の2種類のアーキテクチャが採用されています。

「Xeon 6 6700P/6500P」はコアあたりのパフォーマンスに優れたPコアを採用。データセンターや通信事業者などの幅広い環境およびメインストリームのサーバー、エッジ環境に最適です。

「Xeon 6 6700E」は電力効率に優れたEコアを採用し1CPUで最大144コアというコア数を実現。第2世代 Xeonと比較してワットあたりのパフォーマンスは2.6倍となり、同等の性能に必要なラック数は3分の1に集約することで電力の節約、CO2排出量の削減に大幅に貢献します。また、インテル® アドバンスト・ベクトル・エクステンション 2(インテル® AVX2)と、ベクトル・ニューラル・ネットワーク命令(VNNI)やBF16/FP16用の高速変換といった新しい拡張機能により、AI推論とベクトル指向の演算処理に適応します。

インテル® Xeon® 6 プロセッサー 搭載

インテル® Xeon® 6 プロセッサー

「インテル® Xeon® 6 プロセッサー」は「第5世代 Xeon スケーラブル・プロセッサー」の直接の後継となる新しいデータセンター向けプロセッサーです。

従来の「世代名+スケーラブル」の名称を廃止し、Xeonの後に世代名を意味する数字をナンバリングした「Xeon 6 プロセッサ」へリブランドされました。

「インテル® Xeon® 6 プロセッサー」は、ビックデータの解析や設計業務、AIの学習と推論向けにコアごとのパフォーマンスを最適化したPコア(Performance-core 開発コードネーム:Granite Rapids)、クラウドサービスや高密度のワークロード向けにワットパフォーマンスを最適化したEコア(Efficient-core 開発コードネーム:Sierra Forest)の2種類のアーキテクチャが採用されています。また、パッケージも「Xeon 6 6900シリーズ」に使用される大型のLGA7529と、「Xeon 6 6700シリーズ」で使用される比較的小型のLGA4710の2種類が用意されており、「インテル® Xeon® 6 プロセッサー」には2種類のCPUコアと、2種類のCPUソケットがラインナップされていることになります。

| ワークロード | Performane-core コアあたりのパフォーマンスを最適化 |

Efficient-core ワットあたりのパフォーマンスを最適化 |

|---|---|---|

| HPC | ||

| モデル化 & シミュレーション | ||

| CAE | ||

| ウェブ & マイクロサービス | ||

| クラウド専用 | ||

| 消費者向け デジタルサービス |

||

| アプリケーション Dev Ops | ||

| データベース & 分析 | ||

| CRM, ERP | ||

| ビッグデータ | ||

| インメモリー分析 | ||

| 非構造化 データベース |

||

| スケールアウト分析 | ||

| AI | ||

| 生成AI | ||

| ディープラーニング / マシンラーニング |

||

| 推論 | ||

| インフラストラクチャー & ストレージ | ||

| HCI | ||

| 仮想化 | ||

| ストレージ | ||

| ネットワーキング | ||

| CDN | ||

| メディア & ゲーミング | ||

| ネットワーク ・ マイクロサービス |

||

| クラウドネイティブ CDN |

||

| 5G コア | ||

| エッジ | ||

| ビデオ | ||

| エッジ分析 | ||

| 仮想保護リレー | ||

2種類のCPUコアと、2種類のCPUソケット

「Xeon 6 6900P/6700P/6500P」はパフォーマンスに優れたPコアを採用した高性能コアを搭載し、幅広いワークロードで高いAIパフォーマンスを発揮します。6900シリーズは他のシリーズよりもコア数、メモリー・チャンネル数、I/Oレーン数が多く、熱設計電力(TDP)が高くなっています。

また、従来のDDR5-6400 RDIMMだけでなく同容量でより高いメモリバンド幅を持つMRDIMMにも対応し、最大8800MT/sの転送レートでの利用が可能になります。

「Xeon 6 6900E/6700E」は電力効率に優れたEコアを高密度に搭載。1CPUで最大288コアというコア数を実現し、タスク並列の高スループットを必要とするクラウドスケールのワークロードに明確な優位性をもたらします。また、第2世代 Xeonと比較して2.6倍の電力効率を発揮し、同等の性能に必要なラック数を3分の1に集約することが可能です。

|

|

|

|||

|---|---|---|---|---|

| 製品名 | 6900P | 6900E | 6700P/6500P | 6700E |

| 開発コードネーム | Granite Rapids | Sierra Forest | Granite Rapids | Sierra Forest |

| パッケージ | LGA7529 | LGA4710 | ||

| CPUコア | Pコア(高性能コア) | Eコア(高効率コア) | Pコア(高性能コア) | Eコア(高効率コア) |

| 最大コア数 | 128 | 288 | 86 | 144 |

| マルチスレッド | YES | N/A | YES | N/A |

| 対応ソケット数 | 1,2 | 1,2,4,8 | 1,2 | |

| 最大TDP | 500W | 350W | 330W | |

| メモリチャネル | 12チャネル | 8チャネル | ||

| MRDIMM対応 | YES | N/A | YES | N/A |

| 対応メモリ | DDR5-8800 MRDIMM DDR5-6400 RDIMM |

DDR5-6400 RDIMM | DDR5-8000 MRDIMM DDR5-6400 RDIMM |

DDR5-6400 RDIMM |

| PCIe/CXL | PCIe 5.0 96レーン CXL 2.0 |

PCIe 5.0 88レーン *1S=最大136レーン CXL 2.0 |

||

| UPI 2.0 リンク | 6 | 4 | ||

| UPI 速度 | 24GT/s | 24GT/s | ||

| インテル® Xeon® 6 シリーズ | 対象の導入環境 |

|---|---|

| 6900シリーズ | クラウド、AI、HPCなど、極めて負荷の高い環境に最適な最大レベルのパフォーマンス |

| 6700シリーズ | データセンターや通信事業者など幅広い環境に最適な機能拡張されたパフォーマンス |

| 6500シリーズ | メインストリームのサーバーやエッジの環境に最適な基本のパフォーマンス |

| 6300シリーズ | 中小規模のビジネス環境に最適なエントリーレベルのパフォーマンス |

| インテル® Xeon® 6 | P-core採用 | E-core採用 |

|---|---|---|

6900シリーズ最大パフォーマンス 新たなクラスのサーバー・プラットフォーム設計として展開される、クラウド・コンピューティング、AI、HPC、SaaS、IaaSのワークロードに最適なプロセッサー・シリーズ |

|

|

6700/6500シリーズ拡張されたパフォーマンス 確立されたインテルのサーバー・プラットフォーム設計を大幅にアップグレード。エンタープライズIT、デジタル・サービス・プロバイダー、通信事業者のエッジからクラウドまでメインストリームのサーバーに実装。AI、HPC、ネットワーキング、メディア、データサービス、インフラストラクチャー、ストレージ、ウェブ、アプリケーション、マイクロサービスなど、幅広い用途に最適。 |

|

|

インテル® Xeon® 6 プロセッサー 一覧

関連製品

NVIDIA データセンターGPU H200 NVL 搭載可能

NVIDIA H200 NVL

|

|

|---|---|

| FP64(TFLOPS) | 30 |

| FP64 Tensor コア(TFLOPS) | 60 |

| FP32(TFLOPS) | 60 |

| TF32 Tensor コア(TFLOPS) | 835 |

| BFLOAT16 Tensorコア(TFLOPS) | 1,671 |

| FP16 Tensorコア(TFLOPS) | 1,671 |

| FP8 Tensorコア(TFLOPS) | 3,341 |

| INT8 Tensorコア(TOPS) | 3,341 |

| GPUメモリ | 141GB |

| GPUメモリー帯域幅 | 4.8TB/s |

| デコーダー | 7 NVDEC 7 JPEG |

| コンフィデンシャル コンピューティング | サポート対象 |

| 最大熱設計電力(TDP) | 最大600W(設定可能) |

| マルチインスタンスGPU | 最大7パーティション(各16.5GB) |

| フォームファクター | PCIe デュアルスロット空冷 |

| 相互接続 | 2台または4台構成時のNVIDIA NVLink ブジッジ : GPU1台あたり 900 GB/s PCIe Gen5 : 128 GB/s |

| NVIDIA AI Enterprise | 同梱 |

| 排熱機構 | パッシブ(冷却ファンなし) |

NVIDIA H200 PCle 141GB NVL

NVIDIA H200 NVLは、柔軟な構成が求められる空冷式エンタープライズラック向けに最適化された低消費電力モデルです。あらゆる規模のAIおよびHPC処理に対応する高い処理性能を実現します。最大4基のGPUをNVIDIA NVLink™で接続し、1.5倍のメモリ容量を備えることで、大規模言語モデル (LLM) の推論処理ではH100 NVL比で最大1.7倍、HPC処理では最大1.3倍の性能向上を達成しています。

生成AIとHPCのためのGPU

NVIDIA H200 TensorコアGPUは、市場を一変させるパフォーマンスとメモリ機能で生成AIとHPCワークロードを強化します。HBM3eを搭載した初のGPUであるH200の大容量かつ高速のメモリは、HPCワークロードのための科学コンピューティングを推進しながら、生成AIと大規模言語モデル(LLM)の高速化を促進します。

NVIDIA H200のイノベーション

大容量で高速なメモリによる高いパフォーマンス

NVIDIA HopperアーキテクチャをベースとするNVIDIA H200は、4.8TB/sで141GBのHBM3eメモリを提供する初のGPUです。これは、NVIDIA H100 TensorコアGPUの約2倍の容量で、メモリ帯域幅は1.4倍です。H200の大容量かつ高速なメモリは、生成AIとLLMを加速し、エネルギー効率を向上させ、総所有コストを低減し、HPCワークロードのための科学コンピューティングを前進させます。

高性能なLLM推論でインサイトを引き出す

進化し続けるAIの世界では、企業はさまざまな推論のニーズに対応するためにLLMを利用しています。AI推論アクセラレータは、大規模なユーザーベース向けにデプロイする場合、最小のTCOで最高のスループットを実現する必要があります。

H200は、Llama2のようなLLMを扱う場合、H100 GPUと比較して推論速度を最大2倍向上します。

ハイパフォーマンスコンピューティングをスーパーチャージ

メモリ帯域幅は、より高速なデータ転送を実現することで、ボトルネックとなる複雑な処理を削減するため、ハイパフォーマンスコンピューティングアプリケーションにとって極めて重要です。シミュレーション、科学研究、人工知能のようなメモリを大量に使用するHPCアプリケーションでは、 H200の高いメモリ帯域幅が、データへのアクセスと操作を効率化し、CPUと比較して110倍の早さで結果を得ることができます。

エネルギーとTCOの削減

H200の導入により、エネルギー効率とTCOが新たなレベルに到達します。この最先端のテクノロジーは、すべてH100 TensorコアGPUと同じ電力プロファイル内で、かつてないパフォーマンスを提供します。AIファクトリーとスーパーコンピューティングシステムは、高速なだけでなく、環境にも優しく、AIと科学のコミュニティを推進する経済的優位性を提供します。

関連製品

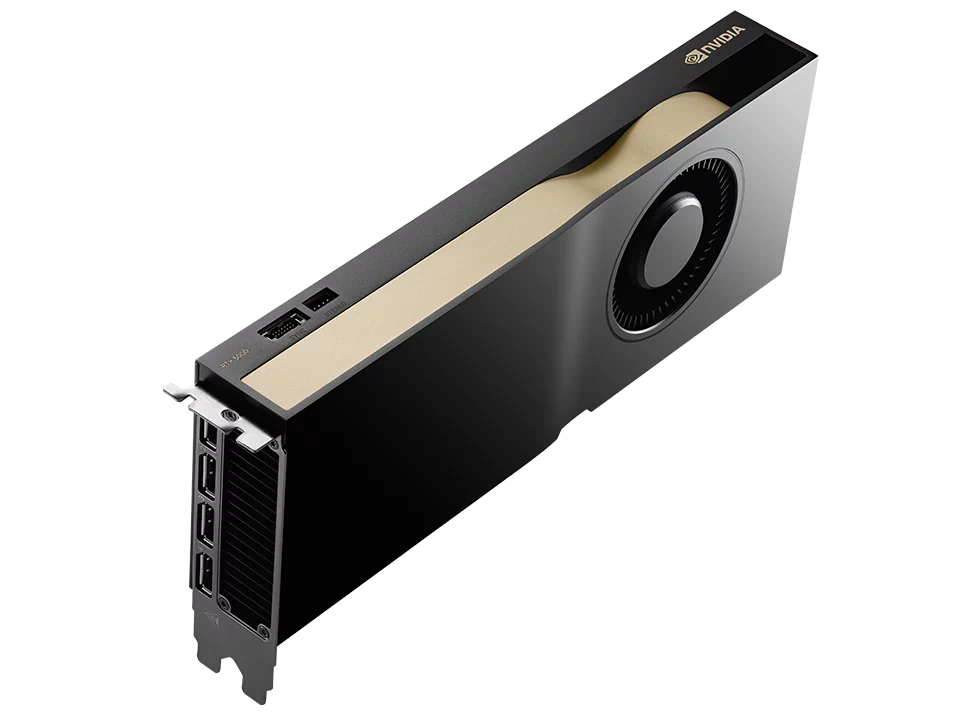

NVIDIA RTX™ PRO Blackwell Server Edition 搭載可能

NVIDIA RTX™ PRO Blackwell

Server Edition |

Workstation Edition |

Max-Q Workstation Edition |

|

|

|

|||||

|---|---|---|---|---|---|---|---|---|---|---|

| GPUアーキテクチャ | Blackwell | Blackwell | Blackwell | Blackwell | Blackwell | Blackwell | ||||

| CUDAコア | 24,064 | 24,064 | 24,064 | 14,080 | 10,496 | 8,960 | ||||

| Tensorコア | 752 | 752 | 752 | 第5世代 | 328 | 280 | ||||

| RTコア | 188 | 188 | 188 | 第4世代 | 82 | 70 | ||||

| AI パフォーマンス | 3.7 PFLOPS | 4000 AI TOPS | 3511 AI TOPS | 2064 AI TOPS | 1687 AI TOPS | – | ||||

| 単精度性能(TFLOPS) | 120 | 125 | 110 | 65 | – | – | ||||

| RTコア性能(TFLOPS) | 355 | 380 | 333 | 196 | – | – | ||||

| GPUメモリ | 96GB GDDR7 ECC | 96GB GDDR7 ECC | 96GB GDDR7 ECC | 72GB/48GB GDDR7 ECC | 32GB GDDR7 ECC | 24GB GDDR7 ECC | ||||

| メモリ インターフェイス | 512-bit | 512-bit | 512-bit | 512-bit | 256-bit | 192-bit | ||||

| メモリ帯域幅 | 1597 GB/s | 1792 GB/s | 1792 GB/s | 1344 GB/s | 896 GB/s | – | ||||

| システムインターフェイス | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | ||||

| 最大消費電力 | 600W | 600W | 300W | 300W | 200W | 140W | ||||

| 補助電源コネクタ | PCIe CEM5 16pin x1 | PCIe CEM5 16pin x1 | PCIe CEM5 16pin x1 | PCIe CEM5 16pin x1 | PCIe CEM5 16pin x1 | PCIe CEM5 16pin x1 | ||||

| 排熱機構 | パッシブ | Double-flow-through | アクティブ | アクティブ | アクティブ | アクティブ | ||||

| フォームファクター | 4.4″ H x 10.5 L 2スロット |

5.4″ H x 12″ L 2スロット |

4.4″ H x 10.5 L 2スロット |

4.4″ H x 10.5 L 2スロット |

4.4″ H x 10.5 L 2スロット |

4.4″ H x 9.5 L 1スロット |

||||

| 画面出力 | DisplayPort 2.1 x4 | DisplayPort 2.1 x4 | DisplayPort 2.1 x4 | DisplayPort 2.1 x4 | DisplayPort 2.1 x4 | DisplayPort 2.1 x4 | ||||

| マルチインスタンスGPU | 4x 24GB | 4x 24GB 2x 48GB 1x 96GB |

4x 24GB 2x 48GB 1x 96GB |

|

N / A | N / A | ||||

| NVLink | N / A | N / A | N / A | N / A | N / A | N / A |

NVIDIA Blackwell アーキテクチャ

NVIDIA Blackwellアーキテクチャを搭載したNVIDIA RTX PRO™ 6000 BlackwellシリーズGPUは、比類のないAI計算能力と最先端の視覚パフォーマンスを融合し、プロフェッショナルの可能性を再定義します。 96GBの超高速GDDR7メモリ、第5世代Tensorコア、第4世代RTコアを搭載したRTX PRO 6000シリーズは、エージェント型AI、フィジカルAI、科学計算からフォトリアルなレンダリング、3Dグラフィックス、リアルタイムビデオ処理まで、AIとクリエイティブワークロードの全範囲を加速します。 デスクトップからデータセンターまで、BlackwellアーキテクチャはAIの未来を再定義するITリーダー、研究者、エンジニア、クリエイターに比類のない柔軟性、拡張性、精度を提供します。

中心となるテクノロジ

第 5 世代の Tensor コア

第5世代Tensorコアは前世代比で最大3倍のパフォーマンスを実現し、FP4精度とDLSS 4 マルチ フレーム生成テクノロジのサポートが追加されています。 ローカルLLMの高速化、新しいAIモデルのプロトタイプ作成、コンテンツ作成とグラフィックスの向上を促進します。

第 4 世代の RT コア

第4世代のRTコアは、前世代比で最大2倍のパフォーマンスを実現し、M&Eコンテンツの作成、AECO設計、製造プロトタイピングにおいて、レンダリングを高速化します。 最大100倍のレイ トレーシングの三角ポリゴンを生成可能にするRTX Mega Geometryといったニューラル グラフィックス ベースの技術を使用し、写真のようにリアルで物理的に正確なシーンと臨場感のある3Dデザインを作成できます。

CUDA コア

Blackwellは、最新のSMおよびCUDA® コア テクノロジを搭載した、史上最も強力なプロフェッショナル向けRTX GPUです。 このSMは、処理スループットの向上とプログラマブル シェーダーの内部にニューラル ネットワークを統合する新しいニューラル シェーダーを搭載しています。今後10年間のAI拡張グラフィックスのイノベーションが推進されます。

96 GB の GPU メモリ

新たに改良されたGDDR7メモリにより帯域幅と容量が大幅に増え、アプリケーション実行の高速化と、より大規模で複雑なデータセットの処理が可能になります。 96GBのGPUメモリにより、大規模な3DおよびAIプロジェクトに取り組み、大規模なVR環境を探索し、より大きなマルチアプリ ワークフローを実現できます。

第 9 世代の NVENC

第9世代のNVIDIA NVENCエンジンは、ビデオのエンコード速度を大幅に高速化し、プロフェッショナル ビデオ アプリケーションの品質を向上させます。 4:2:2 H.264およびHEVCエンコーディングの新しいサポートを追加し、HEVCおよびAV1エンコーディング品質を向上させます。

第 6 世代 NVDEC

第6世代のNVIDIA NVDECエンジンは、最大2倍のH.264デコード スループットを実現し、4:2:2 H.264およびHEVCデコードをサポートしています。 プロの編集者は、高品質のビデオ再生、ビデオ データの取り込みの高速化、高度なAIを活用したビデオ編集機能などを使用できるようになります。

マルチインスタンス GPU

マルチインスタンスGPU (MIG) は、最大4つの完全に分離されたインスタンスの作成を可能にすることで、RTX PRO 6000 Server Editionのパフォーマンスと価値を拡張します。 各MIGインスタンスは独自の高帯域幅メモリ、キャッシュ、および計算コアを持ち、サービス品質 (QoS) を保証し、すべてのユーザーに高速コンピューティング リソースを提供します。

PCIe Gen 5

PCI Express Gen 5のサポートにより、PCIe Gen 4と比較して帯域幅が2倍になるため、CPUメモリからのデータ転送速度が向上し、AI、データ サイエンス、3Dモデリングなどのデータ集約型タスクでパフォーマンスが高速化します。

DisplayPort 2.1

DisplayPort 2.1により、プロフェッショナルは比類のない視覚的な明瞭さとパフォーマンスを得ることができ、240Hzで最大8K、60H で最大16Kの高解像度で表示できます。 帯域幅の増加により、マルチタスクや共同作業に理想的な、シームレスなマルチモニターのセットアップが可能になります。また、HDRやより高い色深度のサポートにより、ビデオ編集、3Dデザイン、ライブ配信などの精密な作業での色精度が確保されます。

関連製品

NVIDIA データセンターGPU Ada Lovelace世代 搭載可能

NVIDIA Ada Lovelace

|

販売終了 |

|

|

|---|---|---|---|

| GPUメモリ | 48GB GDDR6 ECC付き | 48GB GDDR6 ECC付き | 24GB GDDR6 ECC付き |

| メモリー帯域幅 | 864GB/s | 864GB/s | 300GB/s |

| インターコネクト インタフェース | PCIe Gen4x16: 64GB/s 双方向 | PCIe Gen4x16: 64GB/s 双方向 | PCIe Gen4x16: 64GB/s |

| CUDA コア数 | 18,176 | 18,176 | 7,424 |

| NVIDIA 第3世代 RT コア | 142 | 142 | 58 |

| NVIDIA 第4世代 Tensor コア | 568 | 568 | 232 |

| RT コア 性能 TFLOPS | 212 | 209 | – |

| FP32 TFLOPS | 91.6 | 90.5 | 30.3 |

| TF32 Tensor コア TFLOPS | 183 | 366 | 90.5 | 181 | 120 |

| BFLOAT16 Tensor コア TFLOPS | 362.05 | 733 | 181.05 | 362.1 | 242 |

| FP16 Tensor コア | 362.05 | 733 | 181.05 | 362.1 | 242 |

| FP8 Tensor コア | 733 | 1466 | 362 | 724 | 485 |

| ピーク INT8 Tensor TOPS | 733 | 1466 | 362 | 724 | 485 |

| ピーク INT4 Tensor TOPS | 733 | 1466 | 724 | 1448 | – |

| 最大消費電力 | 350W | 300W | 72W |

| フォームファクター | 4.4” (H) x 10.5” (L) 2スロット |

4.4” (H) x 10.5” (L) 2スロット |

ロープロファイル 1スロット |

| 排熱機構 | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) | パッシブ(冷却ファンなし) |

| ディスプレイポート | 4 x DisplayPort 1.4a | 4 x DisplayPort 1.4a | N/A |

| マルチインスタンスGPU | N/A | N/A | N/A |

| NVLink | N/A | N/A | N/A |

NVIDIA Ada Lovelace アーキテクチャ

Ada GPU アーキテクチャは、レイ トレーシングと AI ベースのニューラル グラフィックスに革新的な性能を実現できるように設計されています。GPU 性能のベースラインが劇的に上がり、レイ トレーシングとニューラル グラフィックスの転換点となります。

CUDA® コア

Transformer Engine

単精度浮動小数点 (FP32) スループットの高速化と電力効率の向上により、3D モデル開発や CAE シミュレーションなどのワークフローでパフォーマンスが大幅に向上します。混合精度ワークロード向けの拡張 16 ビット数学機能 (BF16) をサポート。

第 3 世代 RT コア

スループットとコンカレント レイ トレーシングとシェーディング機能が強化され、レイ トレーシングのパフォーマンスが向上し、製品の設計/アーキテクチャ、エンジニアリング、建設のワークフローのレンダリングが高速化します。ハードウェアでモーション ブラーを高速化し、驚異的なリアルタイム アニメーションを実現する実物のようなデザインをご覧ください。

第 4 世代 Tensor コア

構造的なスパース性と最適化された TF32 形式のハードウェア サポートにより、すぐにパフォーマンスが向上し、AI とデータ サイエンス のモデル トレーニングが高速化します。DLSS を含む AI により強化されたグラフィックス機能を加速させ、選ばれたアプリケーションで優れたパフォーマンスで高解像度を実現します。

48GB の GPU メモリ

48GB の超高速 GDDR6 メモリで、データ サイエンス、シミュレーション、3D モデリング、レンダリングなどの、メモリ負荷の高いアプリケーションやワークロードに対応します。vGPU ソフトウェアを使用して複数のユーザーにメモリを割り当て、クリエイティブ チーム、データ サイエンス チーム、デザイン チーム間で大規模なワークロードを分散します。

仮想化対応

NVIDIA 仮想 GPU (vGPU) ソフトウェア を活用した次世代の改善により、リモート ユーザーがより大規模かつパワフルな仮想ワークステーションのインスタンスを使用できるようになり、高度なデザイン、AI、計算処理におけるより大規模なワークフローが可能になります。

PCI Express Gen 4

PCI Express Gen 4 対応により、PCIe Gen 3 の 2 倍の帯域幅を提供することで、AI やデータサイエンスなどのデータ集約型タスク向けに CPU メモリからのデータ転送速度が向上します。

データ センターの効率性とセキュリティ

NVIDIA L40 は、24 時間 365 日稼動のエンタープライズ データ センター運用に最適化されており、最大限のパフォーマンス、耐久性、アップタイムを確保するために、NVIDIA によって設計、構築、広範囲にテスト、サポートされています。受動冷却、フルハイト フルレングス (FHFL)、デュアルスロット デザイン、最大 300W のボード電力などの特徴を備え、主要な OEM ベンダーのさまざまな筐体構成に収まります。最新のデータ センター標準を満たし、NEBS レベル 3 に対応し、Root of Trust 技術によるセキュア ブートを備え、データ センターにさらなるセキュリティ層を提供します。

関連製品

NVIDIA RTX™ Ada Lovelace世代 搭載可能

NVIDIA RTX™ Ada世代

|

|

|

|

|

|

|

|---|---|---|---|---|---|---|

| GPUメモリ | 48GB GDDR6 | 32GB GDDR6 | 24GB GDDR6 | 20GB GDDR6 | 20GB GDDR6 | 16GB GDDR6 |

| メモリー帯域幅 | 960GB/s | 576GB/s | 432GB/s | 360GB/s | 280GB/s | 224GB/s |

| ECC | Yes | Yes | Yes | Yes | Yes | Yes |

| CUDAコア | 18,176 | 12,800 | 7,680 | 6,144 | 6,144 | 2816 |

| Tensorコア | 568 | 400 | 240 | 192 | 192 | 88 |

| RTコア | 142 | 100 | 60 | 48 | 48 | 22 |

| 単精度性能(TFLOPS) | 91.1 | 65.3 | 39.6 | 26.7 | 19.2 | 12.0 |

| RTコア性能(TFLOPS) | 210.6 | 151.0 | 91.6 | 61.8 | 44.3 | 27.7 |

| Tensor性能(TFLOPS) | 1,457.0 | 1,044.4 | 634.0 | 327.6 | 306.8 | 191.9 |

| NVLink | N / A | N / A | N / A | N / A | N / A | N / A |

| NVLink帯域幅 | N / A | N / A | N / A | N / A | N / A | N / A |

| システムインターフェイス | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x8 |

| 最大消費電力 | 300W | 250W | 210W | 130W | 70W | 70W |

| 排熱機構 | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ | アクティブ |

| フォームファクター | 4.4″ H x 10.5″ L 2スロット |

4.4″ H x 10.5″ L 2スロット |

4.4″ H x 10.5″ L 2スロット |

4.4″ H x 9.5″ L 1スロット |

2.7″ H x 6.6″ L 2スロット |

2.7″ H x 6.6″ L 2スロット |

| 画面出力 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | DisplayPort 1.4a x4 | Mini DisplayPort 1.4a x4 | Mini DisplayPort 1.4a x4 |

NVIDIA Ada Lovelace アーキテクチャ

NVIDIA RTX™ Ada 世代は、現代のプロフェッショナル ワークフローの課題に対応する特徴、機能、パフォーマンスを提供します。NVIDIA Ada Lovelace アーキテクチャで構築された RTX 6000 は、第 3 世代の RT コア、第 4 世代の Tensor コア、次世代 CUDA® コアを 48GB のグラフィックス メモリを組み合わせ、かつてないレンダリング、AI グラフィックス、コンピューティング パフォーマンスを実現します。NVIDIA RTX 6000 搭載ワークステーションは、今日の非常に困難なビジネス環境で成功するために必要なものを提供します。

中心となるテクノロジ

NVIDIA CUDA コア

単精度浮動小数点 (FP32) 演算の倍速処理により、デスクトップにおける複雑な 3D のコンピューター支援設計 (CAD) とコンピューター支援エンジニアリング (CAE) などのグラフィックスやシミュレーションのワークフローに適した驚異的なパフォーマンス向上を実現します。

第 3 世代 RT コア

前世代と比較して最大 2 倍のスループットを備えた第 3 世代 RT コアにより、動画コンテンツのフォトリアルなレンダリング、建築デザインの評価、製品デザインの仮想プロトタイプなどのワークロードのための圧倒的な高速化を実現します。このテクノロジにより、レイ トレーシングによるモーション ブラー レンダリングをより高いビジュアル精度で高速化することができます。

第 4 世代 Tensor コア

第 4 世代の Tensor コアは、より高速な AI コンピューティング パフォーマンスを提供し、前世代の 2 倍以上のパフォーマンスを実現します。これらの新しい Tensor コアは、FP8 精度データ型の高速化をサポートし、独立した浮動小数点と整数のデータ パスを提供し、浮動小数点と整数を混合した計算の実行を高速化します。

48GB GPU メモリ

48GB GDDR6 メモリを搭載した RTX 6000 は、データ サイエンティスト、エンジニア、クリエイティブなプロフェッショナル向けに、レンダリング、データ サイエンス、シミュレーションなどの膨大なデータセットやワークロードを使用する作業に必要な大容量メモリを提供します。

仮想化対応

NVIDIA RTX 仮想ワークステーション (vWS) ソフトウェアをサポートすることで、個人のワークステーションを複数のハイパフォーマンスな仮想ワークステーション インスタンスとして使用できるため、リモートのユーザーがリソースを共有して、ハイエンドのデザイン、AI、コンピューティングのワークロードを進めることができます。

PCIe Gen 4

PCI Express Gen 4 対応により、PCIe Gen 3 の 2 倍の帯域幅を提供することで、AI やデータ サイエンスなどのデータ集約型タスク向けに CPU メモリからのデータ転送速度が向上します。

関連製品

製品仕様

| CPU |

インテル Xeon 6 6700P プロセッサー

x 2

or インテル Xeon 6 6700P プロセッサーor インテル Xeon 6 6500P プロセッサーインテル Xeon 6 6700E プロセッサー |

|---|---|

| チップセット | System on Chip ( SoC ) |

| メモリ | DDR5-6400MHz ECC RDIMM x 32 |

| ドライブベイ | 2.5インチ ホットスワップ ( NVMe 対応 ) x 8 |

| M.2スロット | インターフェイス : PCI-Express 5.0 x4 ( NVMe 対応 ) フォームファクタ : 2280/22110 x 2 |

| オプティカルドライブ | USB接続 外付けDVDマルチドライブ オプション |

| グラフィックス | オンボード |

| GPU | 2スロット GPU 最大 x 8

NVLink ブリッジ オプション |

| ネットワークI/F | 10ギガビット イーサネット ( RJ45 ) x 2 |

| 管理I/F | BMC / IPMI 2.0 |

| I/Oポート 前面 | Mini Display ポート x 1

USB 5Gbps x 2 |

| I/Oポート 背面 | USB 5Gbps x 1

IPMI用 MLAN ( RJ45 ) x 1 |

| 拡張スロット 前面 | PCI Express 5.0 x8 ( FHHL x16Slot ) x 1 |

| 拡張スロット 背面 | PCI Express 5.0 x16 ( FHFL ) x 8

PCI Express 5.0 x16 ( FHHL ) x 5 |

| ケース | 4Uラックマウントケース : W 439.5mm x H 175mm x D 800mm |

| 電源 | 100V 1500W / 200V 2940W x 4 (3+1) リダンダント電源 80-plus Titanium |

| OS |

|

| 保守 | 1年間全国出張オンサイトサービス 3年間全国出張オンサイト オプション |

| 動作推奨環境 | 温度 : 10 ℃ ~ 35 ℃ 湿度 : 20 % ~ 80 % (結露なきこと) |

カタログ

商標について

- Intel、インテル、Intel ロゴ、Intel Inside、Intel Inside ロゴ、Intel Atom、Intel Atom Inside、Intel Core、Core Inside、Intel vPro、vPro Inside、Celeron、Celeron Inside、Itanium、Itanium Inside、Pentium、Pentium Inside、Xeon、Xeon Phi、Xeon Inside、Ultrabook は、アメリカ合衆国および/またはその他の国におけるIntel Corporation の商標です。

- AMD、AMD EPYC™、AMD Ryzen™ 、AMD Radeon™ 、Radeon Instinct™ は、アメリカ合衆国および/またはその他の国におけるAdvanced Micro Devices,Incの商標です。

- NVIDIA、NVIDIA のロゴ、GeForce、 CUDA、 NVLINK、SLI、Tesla、Quadro、および SHIELD は、米国またはその他の国における NVIDIA Corporation の商標または登録商標です

- Supermicroは商標であり、米国のSuper Micro Computer, Inc.およびその他の国における子会社の登録商標です。

- Red Hat、Red Hat Enterprise Linux、Shadowmanロゴ、JBossは米国およびその他の国において登録されたRed Hat, Inc.の商標です。

- Linux(R)は米国およびその他の国におけるLinus Torvaldsの登録商標です。

- SUSEおよびSUSEロゴは、米国およびその他の国におけるSUSE LLCの登録商標です。

- VMwareおよびVMwareの製品名は、VMware, Inc.の米国および各国での商標または登録商標です。

- Microsoft、Windows、MS-DOS、Windows NT、Windows Vista、Windows Server、Windows Azure、SQL Serverおよび Microsoft Exchange Serverまたはその他のマイクロソフト製品の名称および製品名は、米国 Microsoft Corporation の、米国およびその他の国における商標または登録商標です。

- UNIXは、米国およびその他の国におけるオープン・グループの登録商標です。

- その他弊社ウェブサイト(本サイト)に表示・記載されている会社名、製品名およびロゴ等は、各社の登録商標または商標です。